AIが書くコードの問題点:最新調査で明らかになった品質とセキュリティリスク

AIが書くコードの問題点:最新調査で明らかになった品質とセキュリティリスク

はじめに

AI支援コーディングツールの普及により、開発者の生産性は大幅に向上していますが、その一方で見過ごせない問題が浮き彫りになっています。2025年12月にCodeRabbitが発表した「State of AI vs Human Code Generation Report」によると、AIが生成したコードは人間が書いたコードと比較して約1.7倍多くの問題を含んでいることが明らかになりました。

また、Veracodeの「2025 GenAI Code Security Report」では、100以上のLLMをテストした結果、45%のケースでセキュリティ脆弱性が発見されています。

本記事では、これらの最新調査結果を基に、AIが生成するコードの具体的な問題点、その原因、そして開発現場で取るべき対策について詳しく解説します。

CodeRabbit調査:AIコードの品質分析

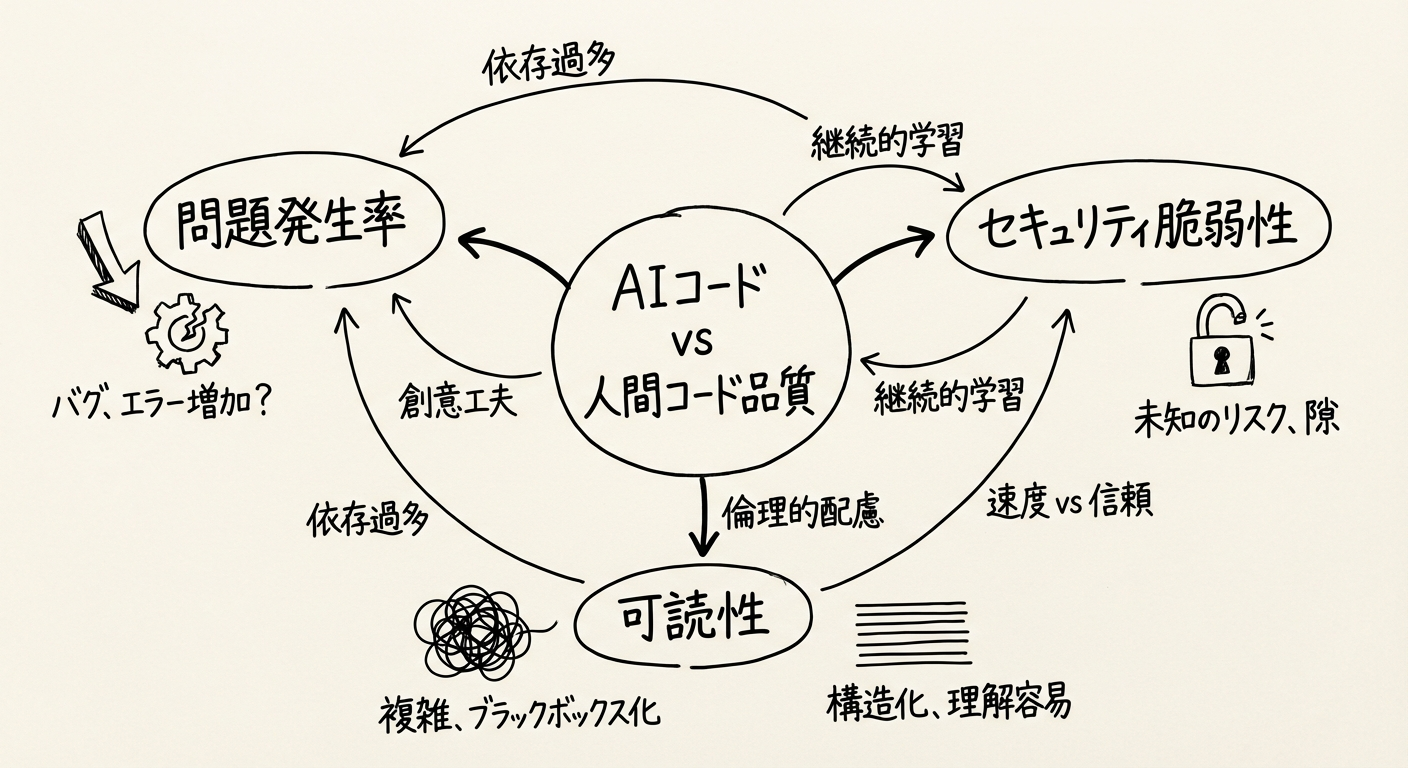

図1: AI生成コードと人間が書いたコードの問題発生率の比較

調査概要

CodeRabbitは、470件のオープンソースGitHub プルリクエスト(PR)を分析しました:

- AI共作PR: 320件

- 人間のみのPR: 150件

この大規模な分析により、AIコード生成ツールが実務環境で引き起こす具体的な問題が明らかになりました。

主要な発見事項

1. 全体的な問題数が1.7倍

AIが生成したPRには、平均して10.83件の問題が含まれていたのに対し、人間が書いたPRでは6.45件でした。つまり、約1.7倍の問題を含んでいることになります。

2. 重大度の高い問題が増加

より深刻なのは、問題の重要度です:

- Critical(重大)レベルの問題: 1.4倍多い

- Major(主要)レベルの問題: 1.7倍多い

これは、AIツールが単に些細なミスを増やすだけでなく、システムの安定性やセキュリティに直接影響を与える重大な問題を引き起こしやすいことを示しています。

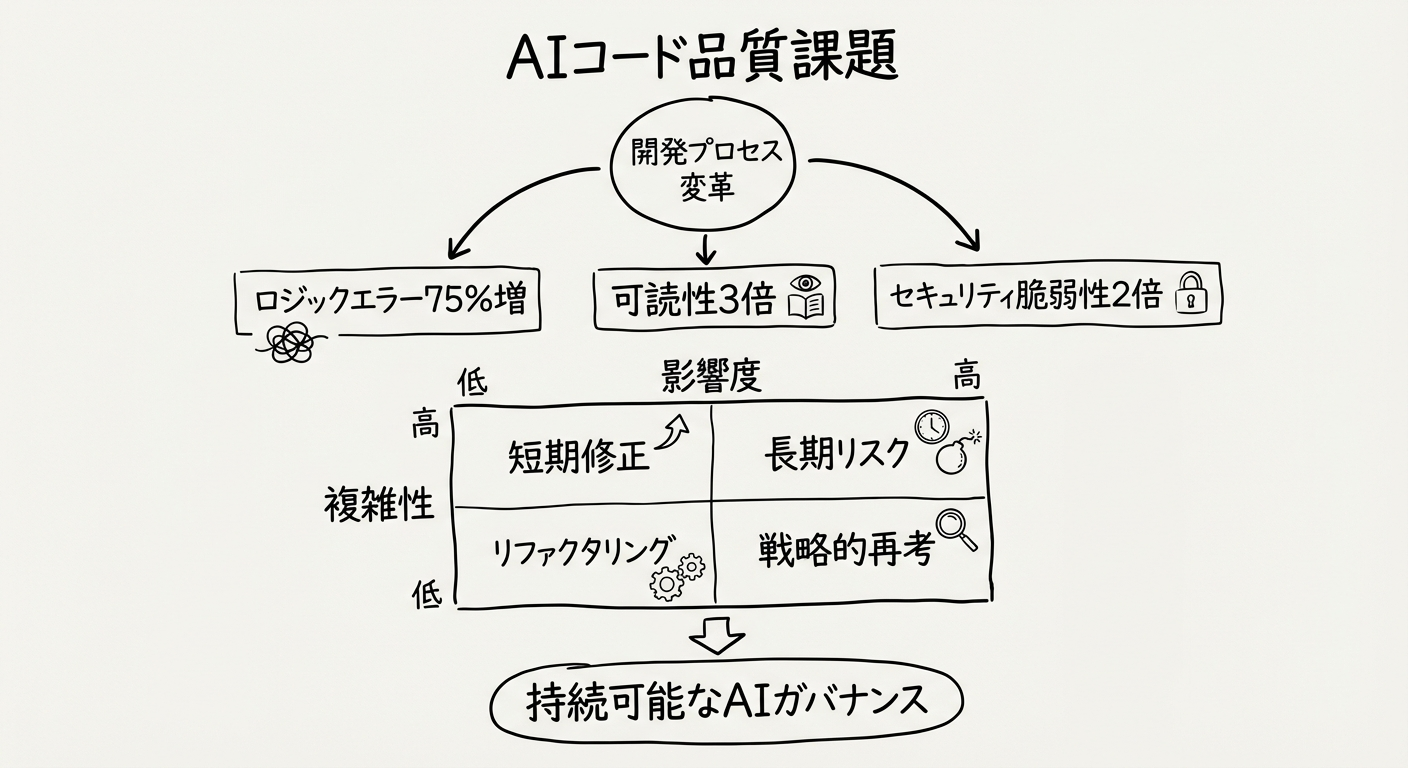

3. ロジックと正確性の問題が75%増

AIコードで最も顕著だった問題は、ロジックと正確性のエラーで、人間のコードと比べて75%多く発生しています。

具体的な問題例:

- 誤ったロジックの実装

- 制御フローの欠陥

- 設定ミス

- 境界条件の処理漏れ

4. 可読性の問題が3倍以上

コードの可読性と保守性に関する問題は、AIコードで3倍以上発生していました。

典型的な問題:

- 不明瞭な変数名

- 不適切なコメントや説明の欠如

- コードの構造が複雑で理解しにくい

- 一貫性のないコーディングスタイル

これは、AIがコードを「動作させる」ことには長けている一方で、他の開発者が読んで理解しやすいコードを書くことには課題があることを示しています。

5. エラーハンドリングの欠陥が約2倍

適切なエラー処理は、堅牢なアプリケーションに不可欠ですが、AIコードではエラーハンドリングの問題が約2倍発生していました。

主な問題:

- 例外処理の欠如

- 不適切なエラーメッセージ

- エラー状態からの回復処理の欠如

- エッジケースへの対応漏れ

6. セキュリティ脆弱性の大幅増加

特に懸念されるのは、セキュリティ関連の脆弱性です:

- 不適切なパスワード処理: 1.88倍多い

- 安全でないオブジェクト参照: 1.91倍多い

- クロスサイトスクリプティング(XSS)脆弱性: 2.74倍多い

これらの脆弱性は、攻撃者に悪用される可能性があり、深刻なセキュリティインシデントにつながる危険性があります。

7. その他の重要な問題

- パフォーマンス低下: AI生成コードに大きく偏っている

- 並行処理の問題: 約2倍増加

- 依存関係の正確性: 約2倍増加

- レビュー負荷の増加: 問題の多いPRがAIコードに集中し、レビュー工数が増大

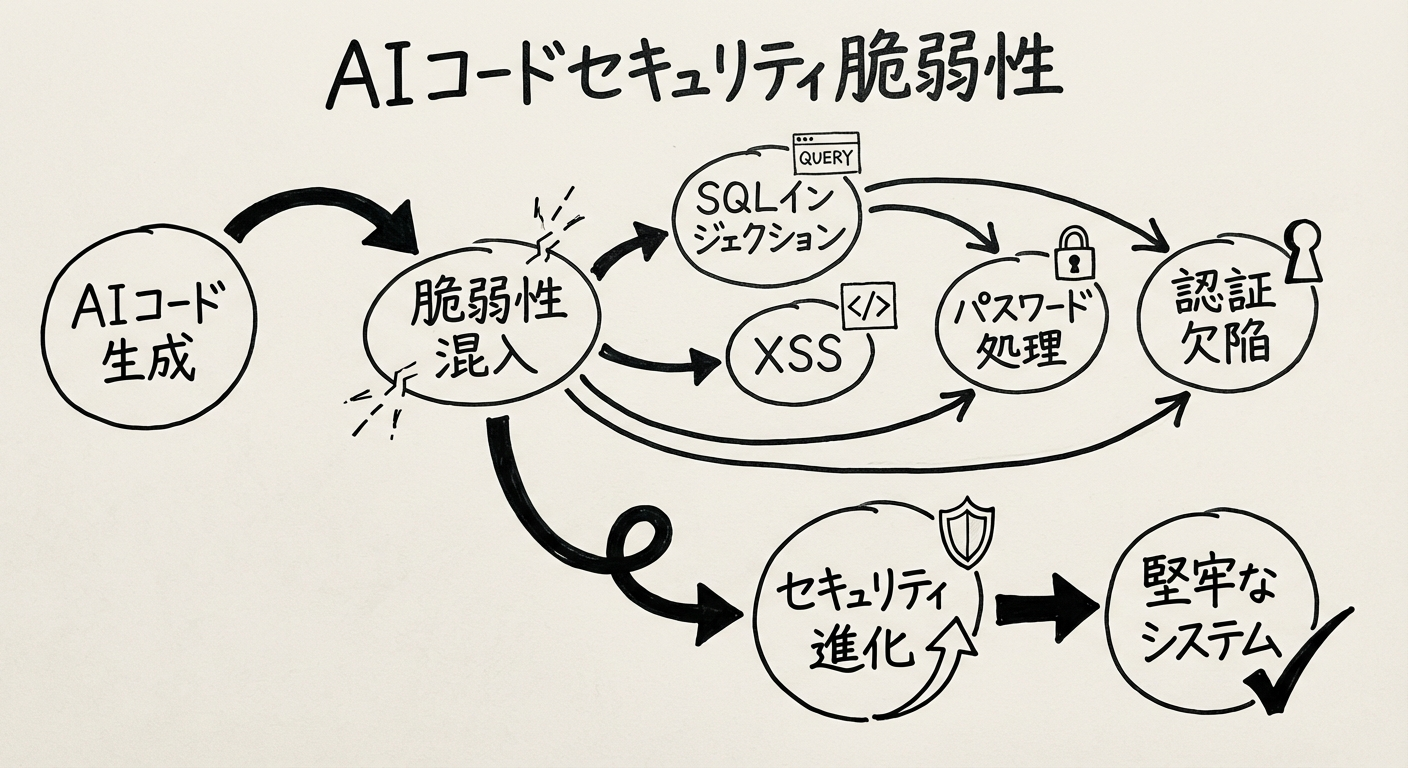

Veracodeレポート:セキュリティ脆弱性の実態

図2: AI生成コードで発見されたセキュリティ脆弱性の種類

Veracodeの「2025 GenAI Code Security Report」では、100以上のLLMをテストし、生成されたコードのセキュリティを評価しました。

主要な発見

- 45%のケースでセキュリティ脆弱性を発見

- SQLインジェクション、XSS、認証の欠陥などの古典的な脆弱性が依然として発生

- セキュリティのベストプラクティスに対する理解が不十分

- 脆弱なライブラリやAPIの使用を推奨するケースが存在

脆弱性が生じる理由

- トレーニングデータの質: 不安全なコード例が学習データに含まれている可能性

- セキュリティコンテキストの欠如: AIはビジネスロジックのセキュリティ要件を理解できない

- パターンマッチングの限界: セキュアコーディングの原則よりも、よく見られるパターンを優先

- 最新の脅威への対応遅れ: 新しい脆弱性パターンが学習データに反映されるまでに時間がかかる

なぜAIコードに問題が多いのか

1. コンテキスト理解の限界

AIツールは、コードの断片的な理解に基づいて生成を行うため、プロジェクト全体のアーキテクチャや設計意図を完全には理解できません。

2. エッジケースへの対応不足

一般的なユースケースには対応できても、例外的な状況やエッジケースへの対処が不十分になりがちです。

3. セキュリティ意識の欠如

AIモデルは「動作するコード」を生成することに最適化されており、セキュリティのベストプラクティスは二の次になることがあります。

4. トレーニングデータの偏り

学習データには、品質の低いコードや古いパターンも含まれており、それがそのまま生成されるコードに反映されます。

5. テストとバリデーションの欠如

AIは生成したコードを実際にテストしたり、エラーケースを検証したりすることができません。

開発現場への影響

生産性のパラドックス

AIツールは確かにコードを速く書きますが、その後の品質保証やデバッグに多くの時間を要するため、全体的な生産性向上は想定よりも小さい可能性があります。

コードレビュー負荷の増加

CodeRabbitの調査では、AIが生成したPRのレビューにはより多くの時間と注意が必要であることが示されています。特に、以下の点でレビュー負荷が増加します:

- 問題の数が多い

- 重大な問題が隠れている可能性

- コードの意図を理解するのに時間がかかる

- セキュリティ脆弱性の見落としリスク

技術的負債の蓄積

可読性が低く、保守性に欠けるコードが蓄積されると、長期的には技術的負債として組織に重くのしかかります。

セキュリティリスクの増大

脆弱性を含むコードが本番環境にデプロイされると、組織全体のセキュリティポスチャが低下します。

AIコードを安全に活用するための対策

1. 厳格なコードレビュープロセス

推奨事項:

- AIが生成したコードには、特に慎重なレビューを実施

- セキュリティに詳しいレビュアーを含める

- 自動化されたコード品質チェックツールを活用

- レビューチェックリストにAI特有の問題項目を追加

2. 静的解析ツールの導入

AIコードの問題を早期に発見するため、以下のツールを活用:

- SonarQube: コード品質とセキュリティ脆弱性の検出

- ESLint/Pylint: 言語別のリンターで一貫性を確保

- Snyk/Dependabot: 依存関係の脆弱性スキャン

- CodeQL: セキュリティ脆弱性の高度な分析

3. セキュリティテストの強化

- SAST(静的アプリケーションセキュリティテスト): コードレベルの脆弱性検出

- DAST(動的アプリケーションセキュリティテスト): 実行時の脆弱性検査

- ペネトレーションテスト: 実際の攻撃シナリオでの評価

- 依存関係の脆弱性スキャン: サードパーティライブラリのリスク管理

4. AI活用のガイドライン策定

組織レベルで定めるべきルール:

- AIツールの使用が許可される場面と禁止される場面の明確化

- セキュリティ要件が厳しいコード(認証、決済など)へのAI使用制限

- 生成されたコードの品質基準

- レビューおよびテストの必須要件

5. 開発者教育の実施

- AIツールの限界と問題点についての理解を深める

- セキュアコーディングのベストプラクティス研修

- AIが生成したコードのレビュー方法のトレーニング

- 実際の脆弱性事例の共有

6. 段階的な導入と検証

推奨アプローチ:

- まずは非クリティカルな機能でAIツールを試験的に使用

- 問題の傾向を分析し、対策を講じる

- 効果を測定しながら適用範囲を拡大

- 継続的にフィードバックループを回す

7. ハイブリッドアプローチの採用

AIと人間の長所を組み合わせる:

- AIに任せる: ボイラープレートコード、単純な関数

- 人間が担当: 複雑なロジック、セキュリティクリティカルな部分、アーキテクチャ設計

- 協力して実施: AIが生成したコードを人間がレビュー・改善

今後の展望

AI開発ツールの進化

現在の問題を認識した上で、AIコード生成ツールベンダーは以下の改善に取り組んでいます:

- コンテキスト理解の向上: プロジェクト全体の構造を把握する能力の強化

- セキュリティ重視の学習: 脆弱性を含まないコード生成の優先

- エラーハンドリングの改善: 例外処理や境界条件への対応強化

- 可読性の向上: より人間が理解しやすいコードの生成

業界標準の策定

AI支援開発に関する業界標準やベストプラクティスが整備されつつあります:

- AIコード生成の品質基準

- セキュリティガイドライン

- レビュープロセスのフレームワーク

- 開発者向けトレーニングプログラム

ツールの統合とエコシステム

AIコード生成ツールと静的解析、テスト、レビューツールの統合が進み、より安全で効率的な開発環境が整備されていくでしょう。

まとめ

AIコード生成ツールは開発速度を大きく向上させる可能性を秘めていますが、CodeRabbitとVeracodeの調査が示すように、品質とセキュリティの面では依然として大きな課題があります。

重要なポイント:

- AIコードは人間のコードの1.7倍の問題を含む

- 特にセキュリティ脆弱性が2〜3倍増加

- 可読性と保守性に大きな課題

- 厳格なレビューと品質管理が不可欠

AIツールを効果的に活用するには、その限界を正しく理解し、適切なガバナンスとセーフガードを設けることが重要です。AIは強力なアシスタントですが、最終的な責任と判断は人間の開発者にあることを忘れてはなりません。

今後、AIツールが進化し、これらの課題が改善されることが期待されますが、現時点では「AIが生成したコードは、人間が慎重にレビューし、検証する必要がある」というアプローチが最も安全かつ効果的です。