AI技術の倫理的課題:2025年に開発者が知るべき最新規制と実践的対策

AI技術の倫理的課題:2025年に開発者が知るべき最新規制と実践的対策

はじめに

2025年はAI倫理において歴史的な転換点となっています。欧州連合(EU)が世界初の包括的AI規制法である「EU AI Act」を全面施行し、日本でも「AI事業者ガイドライン第1.1版」が公表されました。これまで「やるべきこと」とされてきた倫理的配慮が、いまや法的義務として求められる時代に突入したのです。

本記事では、AI開発に携わる方々に向けて、最新の規制動向から実際に起きている訴訟事例、そして具体的にどのような対策を講じるべきかを分かりやすく解説します。

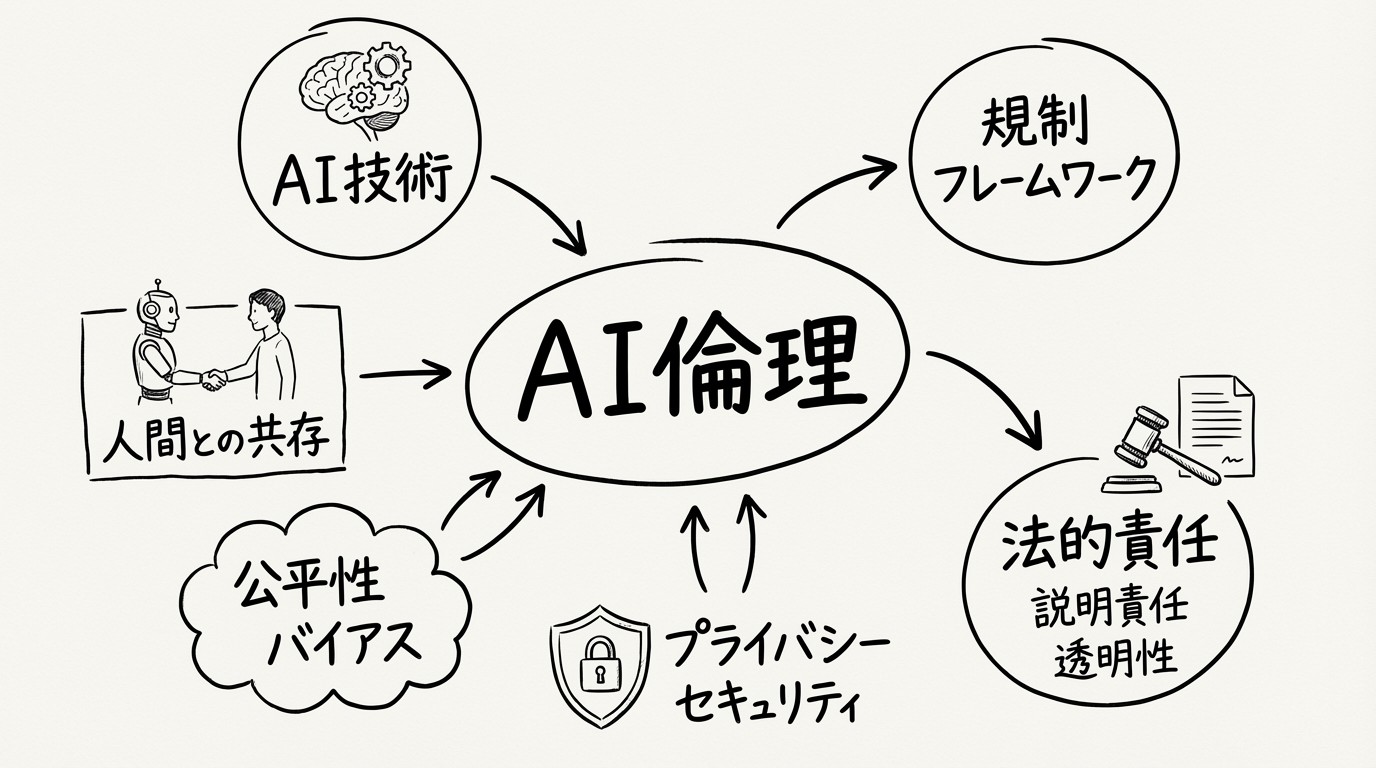

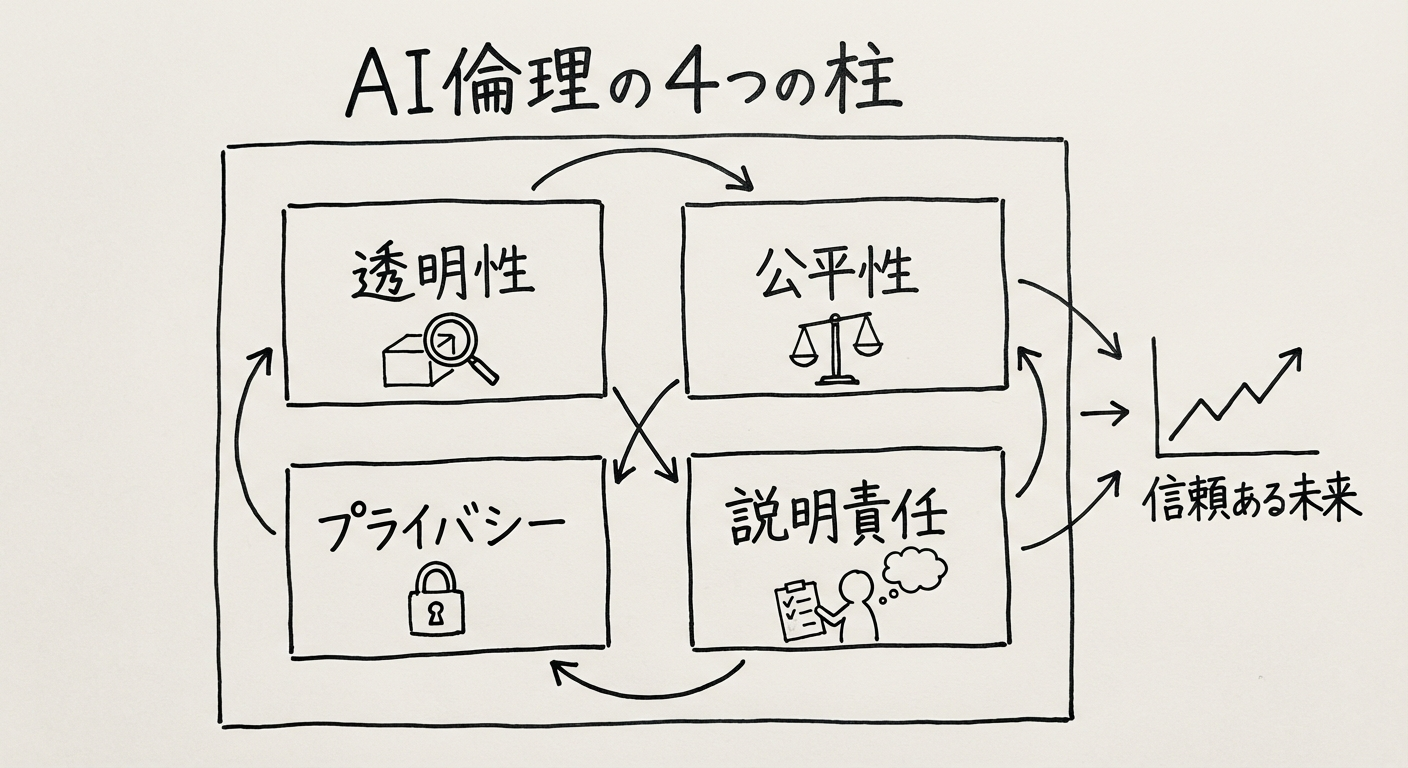

図1: AI倫理の基本原則。透明性、公平性、プライバシー、説明責任の4つが重要

世界の規制動向を理解する

EU AI Act(欧州AI法)とは

EU AI Actは、AIシステムの開発・提供・利用に関する世界初の包括的な法的枠組みです。2025年2月2日に一部が施行され、2025年8月2日には法律が全面施行されます。

この法律の特徴は「リスクベースアプローチ」を採用している点にあります。すべてのAIを一律に規制するのではなく、AIがもたらすリスクの度合いに応じて異なる要件を課します。たとえば、人々の行動を操作するAIや社会的信用スコアリングシステムは「禁止」されます。一方、採用選考や信用審査に使われるAIは「高リスク」に分類され、厳格なリスク管理や人間による監視が義務付けられます。

注目すべき点として、第4条で定められた「AIリテラシー義務」があります。AIを提供または利用する企業は、従業員に対して十分なAI教育を実施しなければなりません。これは技術者だけでなく、AIを業務で使うすべての従業員が対象となります。

日本のAI事業者ガイドライン

経済産業省と総務省が2025年3月に共同で公表した「AI事業者ガイドライン第1.1版」は、日本におけるAI開発・利用の指針を示しています。法的拘束力はありませんが、業界標準として広く参照されています。

このガイドラインの根底にあるのは「人間中心の原則」です。AIは人間の能力を拡張するツールであり、人間の意思決定を完全に代替するものではないという考え方が貫かれています。また、生成AIの普及を受けて、知的財産権の保護や偽情報・誤情報への対策についても具体的な留意事項が追加されました。

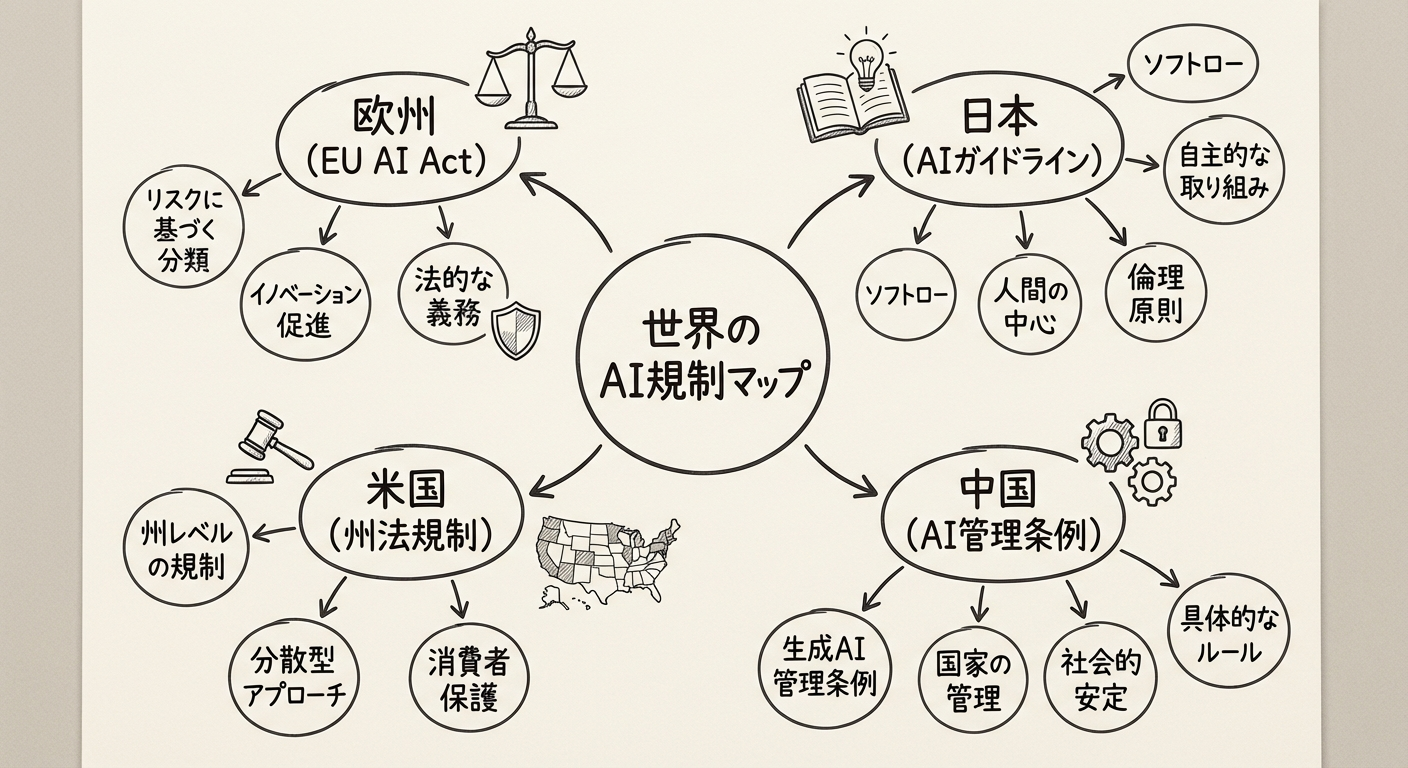

図2: 世界のAI規制マップ。EU AI Act、日本のAIガイドライン、米国の動向を示す

国際的な原則:OECD AI原則

OECDが定めるAI原則は、多くの国の政策やガイドラインの基盤となっています。2024年5月に更新されたこの原則は、包摂的な成長の促進、人権と民主的価値の尊重、透明性と説明可能性の確保、堅牢性とセキュリティの維持、そして説明責任の明確化という5つの柱で構成されています。これらの原則は抽象的に見えるかもしれませんが、具体的な開発指針に落とし込む際の判断基準として機能します。

実際に起きている問題事例

規制が強化される背景には、AIによる具体的な被害事例があります。ここでは2024年から2025年にかけて注目を集めた事例を見ていきましょう。

採用AIをめぐる差別訴訟

米国では、AIを使った採用選考ツールに対する訴訟が相次いでいます。特に注目すべきは「Mobley v. Workday, Inc.」訴訟です。原告は、Workday社のAIスクリーニングツールが応募者の人種、年齢、障害を理由に差別的な選別を行っていると主張しました。2025年5月、連邦裁判所はこの訴訟を年齢差別に関して全国規模の集団訴訟として認定しました。

この訴訟が画期的なのは、AIツールを開発・提供するソフトウェアベンダーも「雇用代理機関」として法的責任を負う可能性が示された点です。これまでは採用を行う企業が主な責任主体と考えられてきましたが、ツール提供者にも責任が及ぶ可能性が開かれたのです。

別の事例として、AIビデオ面接ツール「HireVue」に対する苦情申立てがあります。聴覚障害のある応募者や先住民族の応募者が、AIが発話パターンを適切に処理できないために不利な評価を受けたと訴えています。

ディープフェイクによる企業詐欺

AIの悪用事例として衝撃を与えたのが、2024年2月に発生したArup社の詐欺被害です。世界的なエンジニアリング企業Arup社の財務担当者が、最高財務責任者(CFO)と複数の同僚を模倣したディープフェイクによるビデオ会議に参加してしまいました。画面越しの参加者がすべてAIで生成された偽物であることに気づかず、担当者は2,500万ドル(約38億円)を詐欺師に送金してしまったのです。

この事例は、AI生成の映像や音声が非常にリアルになり、ビデオ会議のような「本人確認済み」と思われる場面でも詐欺が成立しうることを示しています。

医療AIに潜む性別バイアス

2025年8月に発表された研究では、社会福祉サービスの利用可否を判断するAIに性別バイアスが存在することが明らかになりました。このAIは、健康上の問題を抱える男性については「障害がある」「状況が複雑」といった医学的な表現を使う傾向がありました。一方、同様の状態にある女性については「自立している」と表現し、支援の必要性を過小評価する傾向が見られたのです。

結果として、女性が必要なケアや資金援助を受けられないリスクが生じていました。AIが学習データに含まれる社会的偏見をそのまま再現してしまう典型的な例です。

著作権をめぐる訴訟

日本でも2025年8月から9月にかけて、読売新聞、朝日新聞、日本経済新聞などの主要新聞社がAI検索サービス「Perplexity AI」を提訴しました。争点は、記事を無断で学習・解析してAI回答を生成する行為が著作権侵害に該当するかどうかです。この訴訟の行方は、生成AIと著作権の関係を考える上で重要な先例となるでしょう。

主要企業はどう対応しているか

AI倫理への取り組みは、単なるリスク回避ではなく、企業の競争力にも関わる問題となっています。主要AI企業の対応を見てみましょう。

OpenAIの取り組み

OpenAIは「熟慮的アラインメント(Deliberative Alignment)」という新しいアプローチを導入しています。これは、AIモデルが回答を生成する前に、その回答が安全基準に適合しているかどうかを自ら推論する仕組みです。また、計算資源の20%以上を安全性研究に充てることを約束しています。

興味深いのは、2025年6月から7月にかけてAnthropicと相互にモデルの安全性評価を実施したことです。競合他社と協力してAI安全性を検証する姿勢は、業界全体の信頼性向上につながると期待されています。

Googleのアプローチ

Googleは「Responsible AI」の6つの柱として、公平性、信頼性と安全性、プライバシーとセキュリティ、包摂性、透明性、説明責任を掲げています。開発者向けには「Model Cards」というツールを提供し、AIモデルの特性や限界を明文化する取り組みを推進しています。

Microsoftの対策

Microsoftは2025年に「Responsible AI Standard」を更新し、特に先進的なAIモデルに対するより厳格な安全コミットメントを定めました。Azure AI Foundryには155以上のリスク管理機能が統合されており、開発者が倫理的なAIを構築しやすい環境を整備しています。

また、著作権に関しては、組み込みのガードレールを使用して生成されたコンテンツについて、著作権侵害の訴訟から顧客を保護する法的コミットメントを提供しています。

開発者が取るべき具体的な対策

ここまで規制や事例を見てきましたが、実際に開発者はどのような対策を講じるべきでしょうか。

倫理を設計に組み込む

「Ethics by Design(倫理的設計)」という考え方があります。これは、開発の最終段階でチェックを行うのではなく、設計段階から倫理的配慮を組み込むアプローチです。

まず重要なのはバイアス検出です。訓練データに含まれる偏りと、AIの出力に現れる差別的なパターンの両方を検査する仕組みを構築します。特に採用、融資、医療など人々の人生に大きな影響を与える分野では、入念なチェックが必要です。

次に透明性の確保があります。AIがなぜその判断を下したのかを説明できるようにすることで、問題が発生した際の原因究明や改善が可能になります。説明可能AI(Explainable AI)の手法を積極的に採用しましょう。

人間による監視も欠かせません。重要な意思決定にAIを使う場合、最終判断には必ず人間が介入できる仕組みを設計に組み込みます。EU AI Actでも高リスクAIには人間による監視が義務付けられています。

プライバシー保護については、データ最小化(必要最小限のデータのみ収集する)と目的制限(収集目的以外にデータを使用しない)の原則を遵守します。

組織としての準備

EU AI Actへの対応として、まず自社のAIシステムがどのリスクカテゴリに分類されるかを確認する必要があります。高リスクに該当する場合は、コンプライアンス要件を満たすための準備を進めなければなりません。

AIリテラシー教育も重要です。開発チームだけでなく、AIを業務で使用するすべての従業員に対して、AIの仕組み、限界、倫理的な使い方についての教育を実施しましょう。

技術文書、リスク評価レポート、監査証跡といった文書の整備も法的コンプライアンスには不可欠です。問題が発生した際に「どのような判断でこのシステムを設計・運用したか」を説明できる体制を整えておく必要があります。

最後に、AIシステムは運用開始後も継続的にモニタリングすることが重要です。バイアスや有害な出力が新たに発生していないか、定期的に監視する仕組みを構築しましょう。

まとめ

2025年は、AI開発における倫理的配慮が「あったほうがよいもの」から「なければならないもの」へと変わる転換点です。EU AI Actの全面施行により、法的義務として具体的な対応が求められるようになりました。

採用AIの差別訴訟やディープフェイク詐欺といった事例は、AI倫理が理論上の問題ではなく、実際のビジネスリスクであることを示しています。一方で、OpenAI、Google、Microsoftといった企業の取り組みは、倫理的なAI開発が競争力の源泉にもなりうることを示唆しています。

開発者としては、規制動向を継続的にウォッチしながら、設計段階から倫理を組み込む「Ethics by Design」のアプローチを採用することが重要です。バイアス検出、透明性確保、人間による監視といった具体的な施策を実装し、組織全体のAIリテラシー向上に取り組むことで、信頼されるAIシステムを構築していきましょう。