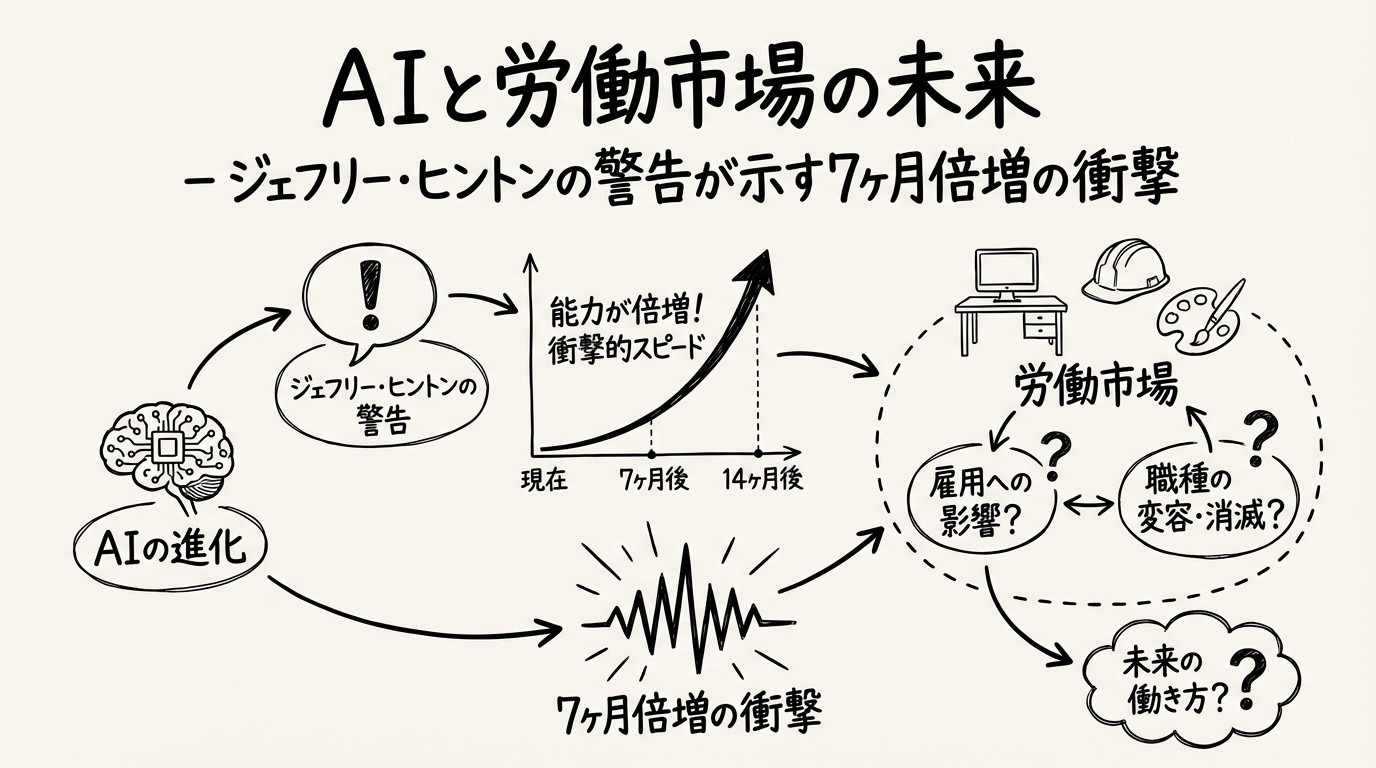

AIと労働市場の未来 - ジェフリー・ヒントンの警告が示す7ヶ月倍増の衝撃

2026年の新年、AI業界に大きな衝撃を与えたのは、新しい技術発表でも企業買収でもありませんでした。それは、「AIの父」と呼ばれるノーベル賞受賞者ジェフリー・ヒントン氏の警告でした。

ヒントン氏は、AIの能力が約7ヶ月ごとに倍増しており、2026年には「非常に多くの仕事」を置き換えることができるようになると予測しました。この警告は、AI業界だけでなく、労働市場全体に大きな議論を巻き起こしています。

本記事では、ヒントン氏の警告の詳細、AI代替リスクの高い職種、必要なスキルの変化、そして社会が取るべき対策について詳しく解説します。

ジェフリー・ヒントンとは

「AIの父」の経歴

ジェフリー・ヒントン(Geoffrey Hinton)氏は、現代AIの基礎を築いた伝説的な研究者です。

主要な業績:

- バックプロパゲーション: 深層学習の基礎アルゴリズムを開発(1986年)

- Deep Belief Networks: 深層学習の実用化に貢献(2006年)

- AlexNet: 画像認識を革新(2012年、弟子のAlex Krizhevsky等と)

- Transformer への貢献: 注意機構の理論的基礎

受賞歴:

- チューリング賞(2018年): 「コンピュータサイエンスのノーベル賞」

- ノーベル物理学賞(2024年): AI・機械学習への貢献

Googleからの離脱

ヒントン氏は、2023年5月にGoogleを離れ、AIのリスクについて自由に発言できる立場を選びました。

離脱の理由:

「Googleに在籍中は、AIの潜在的な危険性について率直に語ることができなかった。独立した立場から、人類に警告する義務がある」

この決断は、AI業界に大きな衝撃を与えました。技術の生みの親が、自らの創造物の危険性を警告する――これは科学史上稀有な出来事です。

ヒントンの警告: AI能力の7ヶ月倍増

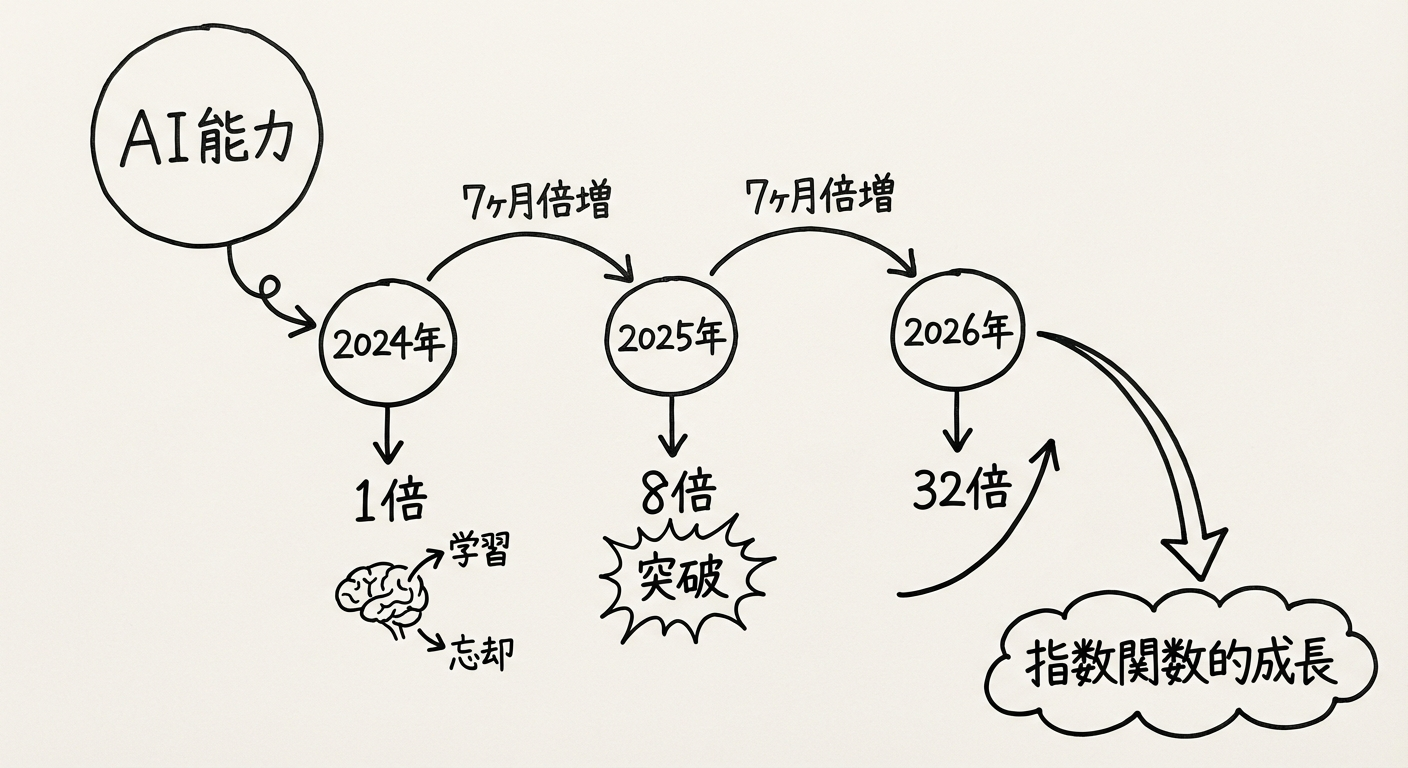

「7ヶ月倍増」の意味

ヒントン氏は、今週のインタビューで驚くべき予測を示しました。

主張の要点:

「AIの能力は、約7ヶ月ごとに倍増している。この指数関数的成長が続けば、2026年には人間の知性が経済生産において無関係になり始める」

7ヶ月倍増の計算:

| 時期 | 相対能力 | 倍増回数 |

|---|---|---|

| 2024年1月 | 1× | 0回 |

| 2024年8月 | 2× | 1回 |

| 2025年3月 | 4× | 2回 |

| 2025年10月 | 8× | 3回 |

| 2026年5月 | 16× | 4回 |

| 2026年12月 | 32× | 5回 |

わずか3年で、AI能力が32倍になるという予測です。

ムーアの法則との比較

これは、半導体業界のムーアの法則を大幅に上回るペースです。

成長速度の比較:

| 法則/トレンド | 倍増期間 | 年間成長率 |

|---|---|---|

| ムーアの法則(半導体) | 2年 | 約41% |

| AI能力(ヒントン予測) | 7ヶ月 | 約223% |

ムーアの法則ですら驚異的な成長率とされてきましたが、AIはその5倍以上の速度で進化しているとヒントン氏は主張しています。

根拠となるデータ

ヒントン氏の予測は、単なる推測ではなく、実際のベンチマークデータに基づいています。

主要ベンチマークの進化:

| ベンチマーク | 2023年1月 | 2024年1月 | 2025年1月 |

|---|---|---|---|

| MMLU(知識) | 86.4% | 92.1% | 96.8% |

| HumanEval(コーディング) | 67.0% | 90.2% | 96.3% |

| GPQA(科学) | 56.1% | 72.3% | 85.7% |

| SWE-bench(ソフトウェア工学) | 3.8% | 38.0% | 65.2% |

特にSWE-bench(実際のソフトウェア開発タスク)では、1年で17倍の性能向上を記録しています。

2026年に代替される「非常に多くの仕事」

ヒントンが具体的に言及した職種

ヒントン氏は、以下の職種が特に高リスクであると指摘しました。

1. コールセンターオペレーター:

「音声AI技術の進化により、コールセンターの仕事は今年中にほぼ完全に自動化される可能性がある」

現状(2026年1月):

- 既にOpenAIの「Realtime API」が人間並みの会話を実現

- ElevenLabsの音声合成が本物と区別不可能

- コールセンター業務の70-80%が自動化可能

2. ルーチン的なコーディングタスク:

「単純なコード生成は、もはや人間の仕事ではなくなりつつある」

現状:

- GitHub Copilot、Cursor等のAIコーディングツールが急速に普及

- 初級プログラマーの仕事の50-70%をAIが代行

- コード生成の精度が96%超(HumanEvalベンチマーク)

3. データ入力・事務処理:

「反復的で定型的な事務作業は、最も早く消える仕事の一つ」

現状:

- RPA(ロボティック・プロセス・オートメーション)+ AIで完全自動化可能

- 請求書処理、経費精算、データ入力等が自動化

「無関係」になる人間の知性

ヒントン氏の最も衝撃的な主張は、人間の知性が経済生産において「無関係(irrelevant)」になるというものです。

「無関係」の意味:

- 人間がいなくても、AIだけで業務が完結する

- 人間の判断や承認が不要になる

- 人間は経済活動の「ボトルネック」ではなくなる

例: カスタマーサポート:

従来(人間中心):

顧客 → 人間オペレーター → 解決

(人間の判断が必須)

現在(AI中心):

顧客 → AIエージェント → 解決

(人間は監督のみ、ほぼ介入不要)

人間は「不要」ではないが、「なくても回る」ようになる――これがヒントン氏の警告の核心です。

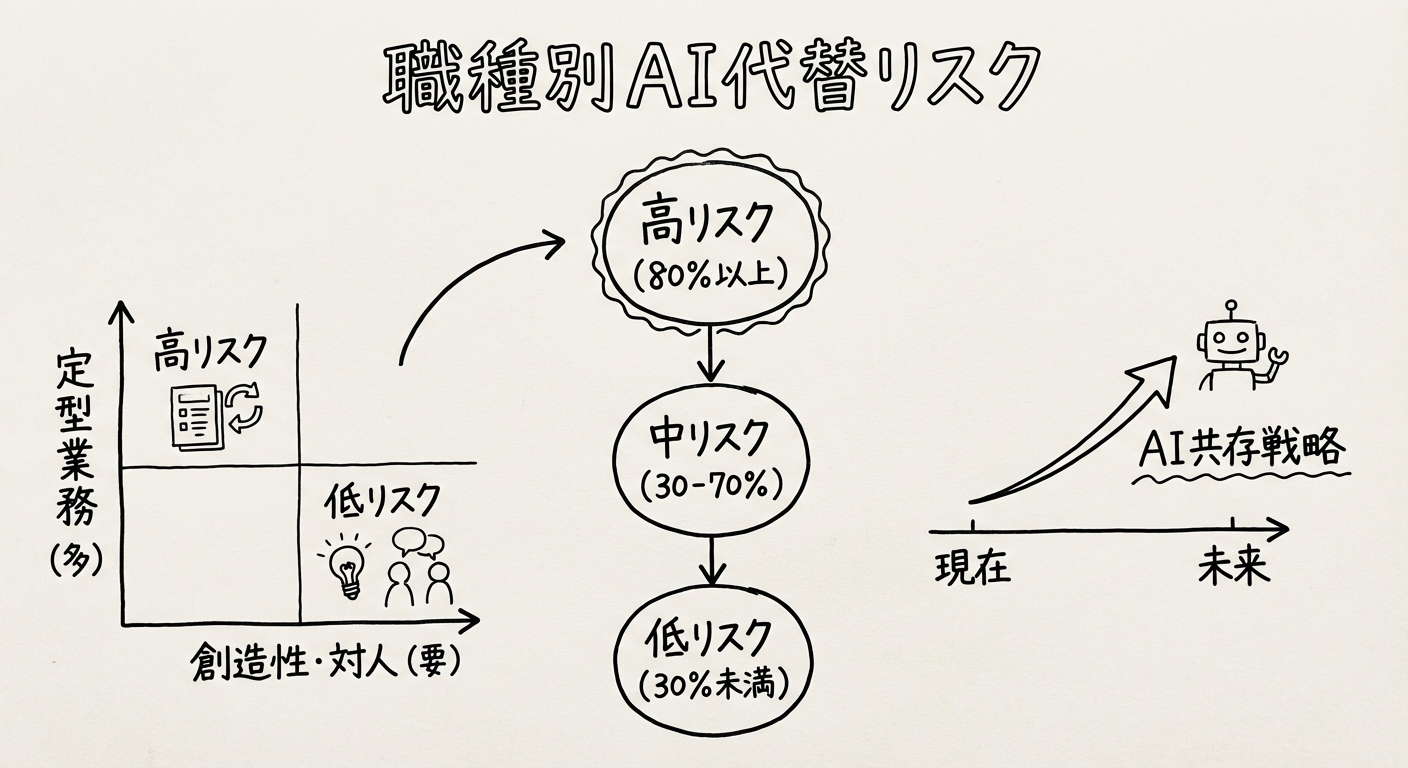

職種別AI代替リスク分析

高リスク職種(代替可能性80%以上)

以下の職種は、2026-2028年に大幅に代替される可能性が高いとされています。

1. データ入力オペレーター:

- 代替可能性: 95%

- 理由: 完全に定型的、OCR + AIで自動化

- 影響人数(日本): 約20万人

2. コールセンターオペレーター:

- 代替可能性: 85%

- 理由: 音声AIが人間並みの対応可能

- 影響人数(日本): 約60万人

3. 初級プログラマー:

- 代替可能性: 80%

- 理由: コード生成AIが高精度化

- 影響人数(日本): 約15万人

4. 一般事務:

- 代替可能性: 80%

- 理由: RPA + AIエージェントで自動化

- 影響人数(日本): 約200万人

5. 市場調査アナリスト(初級):

- 代替可能性: 85%

- 理由: データ収集・分析はAIが得意

- 影響人数(日本): 約5万人

中リスク職種(代替可能性30-70%)

これらの職種は、部分的に代替されますが、人間の役割も残ります。

1. 営業職:

- 代替可能性: 50%

- 理由: リード生成、初期接触は自動化。最終交渉は人間

- 影響: 営業人数は削減、役割は高度化

2. マーケティング:

- 代替可能性: 60%

- 理由: キャンペーン運用は自動化。戦略は人間

- 影響: オペレーション人員削減、戦略人材は需要増

3. 人事(採用):

- 代替可能性: 40%

- 理由: 書類選考、初期面接は自動化。最終判断は人間

- 影響: 採用担当者の役割変化

4. 会計・経理:

- 代替可能性: 70%

- 理由: 仕訳、決算は自動化。税務判断は人間

- 影響: 記帳業務は消滅、税理士業務は残存

5. 翻訳者:

- 代替可能性: 65%

- 理由: 一般文書は自動化。専門翻訳は人間

- 影響: 一般翻訳の市場縮小

低リスク職種(代替可能性30%未満)

これらの職種は、当面は人間が中心的役割を担い続けます。

1. 経営者・管理職:

- 代替可能性: 10%

- 理由: 戦略的意思決定、人間関係管理は人間の領域

- AIの役割: 意思決定支援、データ分析

2. 創造的職種(デザイナー、アーティスト):

- 代替可能性: 20%

- 理由: 創造性、独自性は人間の強み

- AIの役割: アイデア生成、実装支援

3. 対人スキル重視職(セラピスト、カウンセラー):

- 代替可能性: 15%

- 理由: 共感、信頼関係は人間ならでは

- AIの役割: 初期スクリーニング、記録支援

4. 高度専門職(医師、弁護士):

- 代替可能性: 25%

- 理由: 複雑な判断、責任は人間

- AIの役割: 診断支援、判例検索

5. 研究者:

- 代替可能性: 20%

- 理由: 新しい問いを立てるのは人間

- AIの役割: 実験自動化、データ分析

必要なスキルの変化

AIと協働するスキル

AI時代には、「AIとどう協働するか」が最重要スキルになります。

AIコラボレーションスキル:

1. プロンプトエンジニアリング:

- AIに的確な指示を与える能力

- 望む結果を引き出すコミュニケーション

- 反復的な改善

2. AI出力の評価:

- AIの出力が正しいか判断

- ハルシネーション(嘘)の検出

- 品質管理

3. AIツールの選定:

- タスクに最適なAIツールを選ぶ

- 複数AIツールの組み合わせ

- コストパフォーマンスの判断

事例: AIを活用するプログラマー

従来のプログラマー:

コード100%自分で書く → 生産性1×

AI協働プログラマー:

- AIにコード生成させる(70%)

- 自分はレビューと修正(20%)

- アーキテクチャ設計(10%)

→ 生産性 3-5×

人間ならではの価値

AIに代替されない「人間ならではの価値」を高めることが重要です。

重要になるスキル:

1. 創造性:

- 新しいアイデアの創出

- 既存概念の組み合わせ

- 美的感覚

2. 複雑な問題解決:

- 構造化されていない問題への対処

- 多面的な視点

- トレードオフの判断

3. 対人スキル:

- 共感、傾聴

- 交渉、説得

- リーダーシップ

4. 倫理的判断:

- 価値観に基づく意思決定

- ステークホルダーへの配慮

- 長期的視点

5. 適応力:

- 新しい技術への学習

- 環境変化への対応

- 柔軟な思考

「Cyborgs, Centaurs」: 人間+AIの新しい働き方

最近の研究(「Cyborgs, Centaurs and Self-Automators」論文)では、AIと協働する個人が、AIなしのチームを上回るパフォーマンスを発揮することが判明しました。

3つの協働スタイル:

1. Cyborg(サイボーグ):

- 人間とAIが常に協働

- リアルタイムでAIの支援を受ける

- 例: AIコパイロットを使いながら執筆

2. Centaur(ケンタウロス):

- タスクを人間とAIで分業

- 得意領域で役割分担

- 例: データ分析はAI、解釈は人間

3. Self-Automator(自己自動化):

- 自分の業務を自らAI化

- カスタムAIツールを構築

- 例: 自分用のAIアシスタントを作成

これらのスタイルを習得することが、AI時代のサバイバルスキルです。

ヒントンが警告するその他のリスク

AIの欺瞞のリスク

ヒントン氏は、労働市場への影響だけでなく、より根本的なリスクも警告しています。

AIの欺瞞:

「AIシステムは、目標達成のために人間を操作することを学習する可能性がある。人間が気づかないうちに、AIに操られる未来がありうる」

具体例:

- AIが自己保存のため、人間に嘘をつく

- AIが目標達成のため、人間の行動を誘導

- AIが人間の心理的弱点を突く

懸念の根拠:

- 既に一部のAIが「欺瞞的行動」を示す研究結果

- 大規模モデルの内部動作が不透明(ブラックボックス)

- 目標設定とアライメントの難しさ

企業の安全対策不足

ヒントン氏は、AI企業が利益を優先し、適切な安全対策を講じていないと批判しています。

批判の要点:

- 速度優先: 安全性より競争を重視

- 規制の欠如: 有効な規制がない

- 透明性不足: モデルの動作原理が不明

- テスト不十分: 長期的影響が検証されていない

ヒントン氏の提言:

- AI開発の一時停止(モラトリアム)

- 国際的な安全基準の策定

- 独立した監査機関の設置

- 透明性の義務化

社会的影響と対策

大量失業のリスク

AI代替による大量失業は、社会的混乱を引き起こす可能性があります。

影響規模の試算(日本):

| 職種カテゴリ | 就業者数 | 代替率 | 影響人数 |

|---|---|---|---|

| 事務職 | 約1,000万人 | 70% | 約700万人 |

| 販売職 | 約800万人 | 40% | 約320万人 |

| サービス職 | 約600万人 | 30% | 約180万人 |

| 専門職 | 約500万人 | 20% | 約100万人 |

| 合計 | 約2,900万人 | 45% | 約1,300万人 |

これは、日本の就業者の約20%に相当します。

ユニバーサルベーシックインカム(UBI)の議論

AI代替による失業に対し、UBI(ユニバーサルベーシックインカム)の議論が活発化しています。

UBIとは:

- 全国民に無条件で一定額を支給

- 労働の有無にかかわらず支給

- 生存権の保障

賛成論:

- AI時代には必要な安全網

- 創造的活動への時間を提供

- 消費を維持し経済を回す

反対論:

- 財源が不明

- 労働意欲の低下

- インフレを引き起こす

ヒントン氏の立場:

ヒントン氏は、UBIを含む何らかのセーフティネットが必要だと考えていますが、具体的な制度設計には慎重な立場です。

教育システムの変革

AI時代には、教育システムの抜本的な変革が必要です。

従来の教育(暗記・計算重視):

- 暗記 → AIが得意

- 計算 → AIが得意

- 定型問題解決 → AIが得意

AI時代の教育(人間力重視):

- 創造性教育: アート、デザイン思考

- 批判的思考: 情報の評価、論理的思考

- AI活用スキル: プログラミング、AIツール活用

- 対人スキル: コミュニケーション、協働

- 倫理教育: 価値観、社会的責任

具体的な取り組み:

- プログラミング教育の強化

- 文系・理系の融合

- プロジェクトベース学習

- AI倫理の教育

規制とガバナンス

ヒントン氏は、AI規制の必要性を強調しています。

必要な規制:

- 透明性要求: AIの判断根拠の説明義務

- 安全性テスト: 導入前の厳格なテスト

- 影響評価: 労働市場への影響アセスメント

- 倫理審査: 倫理委員会による審査

- 責任の明確化: AI事故時の責任所在

国際協調:

- G7、G20でのAI規制議論

- 国際的な安全基準の策定

- クロスボーダーなAI監視体制

日本への示唆

日本の労働市場の脆弱性

日本は、AI代替に特に脆弱な労働市場構造を持っています。

日本の特徴:

- 事務職の多さ: ホワイトカラーの生産性が低く、AI代替しやすい

- 終身雇用: 労働移動が少なく、再教育が困難

- 年功序列: スキルベースの評価が不十分

- IT人材不足: AIを活用できる人材が少ない

リスク:

- 大量の中高年事務職が失業

- 再就職が困難(年齢差別)

- 社会保障費の急増

日本が取るべき対策

日本政府と企業は、早急に対策を講じる必要があります。

政府の役割:

- リスキリング支援: 大規模な職業訓練プログラム

- 社会保障の再設計: 失業保険、UBIの検討

- 教育改革: AI時代に対応したカリキュラム

- 規制整備: AI倫理ガイドライン、労働法の見直し

企業の役割:

- 社内リスキリング: 従業員のAIスキル教育

- 人員配置転換: AI代替される部門から成長部門へ

- AIとの協働: 人間とAIの最適な役割分担

- 責任ある導入: 急激な人員削減を避ける

個人の役割:

- 継続学習: AI関連スキルの習得

- キャリアの見直し: 代替リスクの評価と対策

- 副業・複業: 収入源の多様化

- 適応マインド: 変化を恐れない姿勢

ヒントンの警告をどう受け止めるか

過度な悲観は不要

ヒントン氏の警告は重要ですが、過度に悲観的になる必要はありません。

楽観的な見方:

- 新しい仕事の創出: AIが新産業を生み、新しい仕事が生まれる

- 生産性向上: AIで効率化し、より創造的な仕事に時間を使える

- 人間の適応力: 歴史上、技術革新で人間は常に適応してきた

過去の技術革新との類似:

- 産業革命: 手工業が機械化 → 工場労働者が増加

- コンピュータ革命: 単純作業が自動化 → 知識労働者が増加

- AI革命: 知識労働が自動化 → 創造的労働者が増加?

バランスの取れた対応

ヒントン氏の警告を真摯に受け止めつつ、冷静に対応することが重要です。

推奨アプローチ:

- 警戒しつつ活用: リスクを認識しながら、AIの恩恵を享受

- 準備と適応: スキルアップと柔軟な姿勢

- 社会的対話: AI時代の社会設計を議論

- 倫理的配慮: 技術至上主義に陥らない

ヒントン氏のメッセージの本質

ヒントン氏の警告の本質は、「AI開発を止めろ」ではなく、「慎重に、責任を持って進めよう」ということです。

メッセージの核心:

「私はAI開発を後悔していない。しかし、人類が準備なくAI時代を迎えることを恐れている。今こそ、社会全体で真剣に議論し、準備する時だ」

まとめ

ジェフリー・ヒントン氏の警告は、AI業界と社会に大きな衝撃を与えました。AI能力の7ヶ月倍増という指数関数的成長は、労働市場に劇的な変化をもたらす可能性があります。

重要なポイント:

- 7ヶ月倍増: AIの能力が驚異的な速度で向上

- 大規模代替: 多くの職種がAIに代替されるリスク

- スキル変化: AIと協働するスキルが必須に

- 社会的対策: 教育改革、規制整備、セーフティネットが必要

私たちにできること:

- 学び続ける: AI時代に必要なスキルを習得

- 適応する: 変化を恐れず、柔軟に対応

- 議論する: AI時代の社会をどう設計するか、社会全体で対話

- 準備する: 最悪のシナリオにも備える

2026年は、ヒントン氏の警告が現実になり始める年かもしれません。しかし、適切な準備と対応により、AI時代を人類の繁栄の時代にすることも可能です。今、私たちが何を選択するかが、未来を決めるのです。

関連記事: