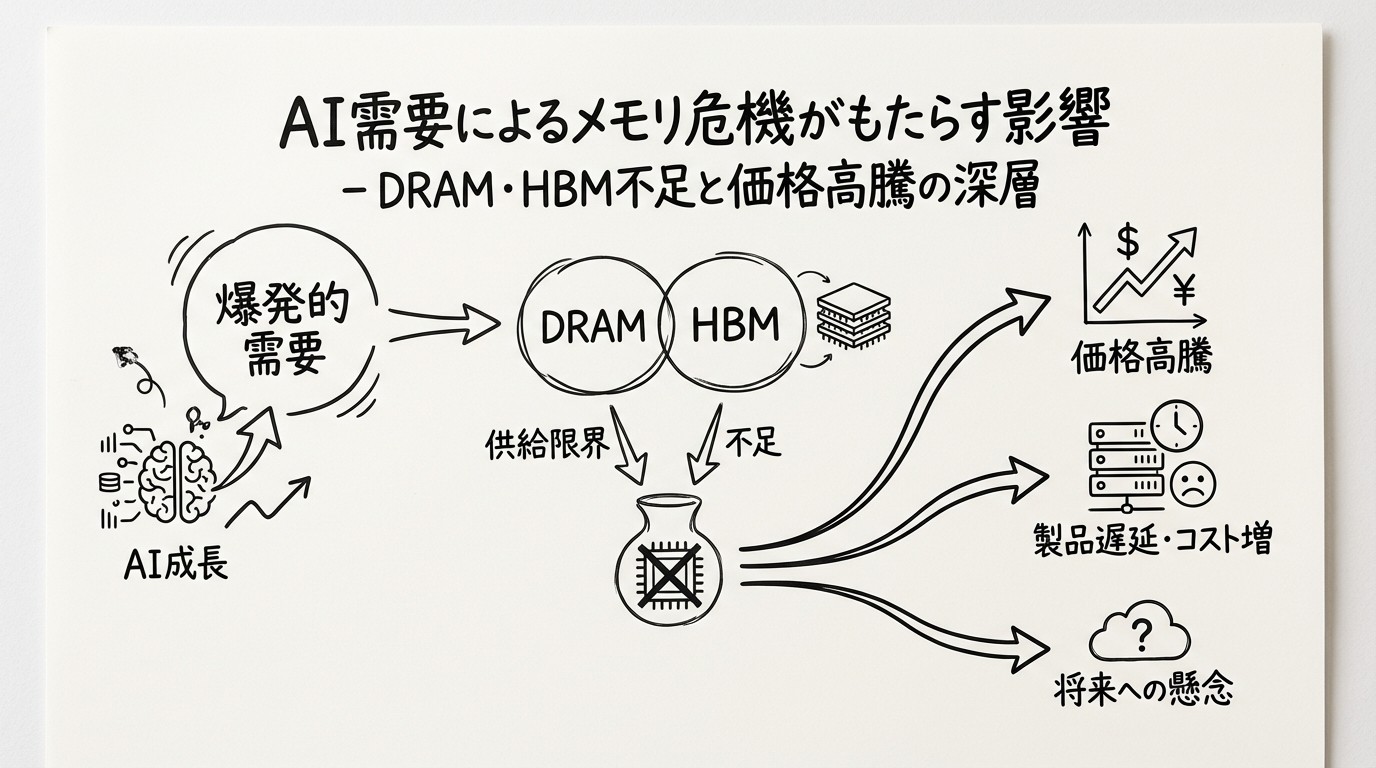

AI需要によるメモリ危機がもたらす影響 - DRAM・HBM不足と価格高騰の深層

2026年の幕開けとともに、AI業界に新たな危機が顕在化しています。AIスケーリングの物理的制約が、DRAM(Dynamic Random Access Memory)とHBM(High Bandwidth Memory)の深刻な不足として現れているのです。

TrendForceのレポートによれば、AI関連メモリの需要が供給を大幅に上回っており、この「メモリ危機」は2027年まで続くと予測されています。本記事では、この危機の詳細、メモリメーカーの戦略、コンシューマ市場への影響、そして日本企業への示唆を詳しく解説します。

メモリ危機の全容

供給需要の深刻な不均衡

2026年初頭、メモリ市場は歴史的な供給不足に陥っています。

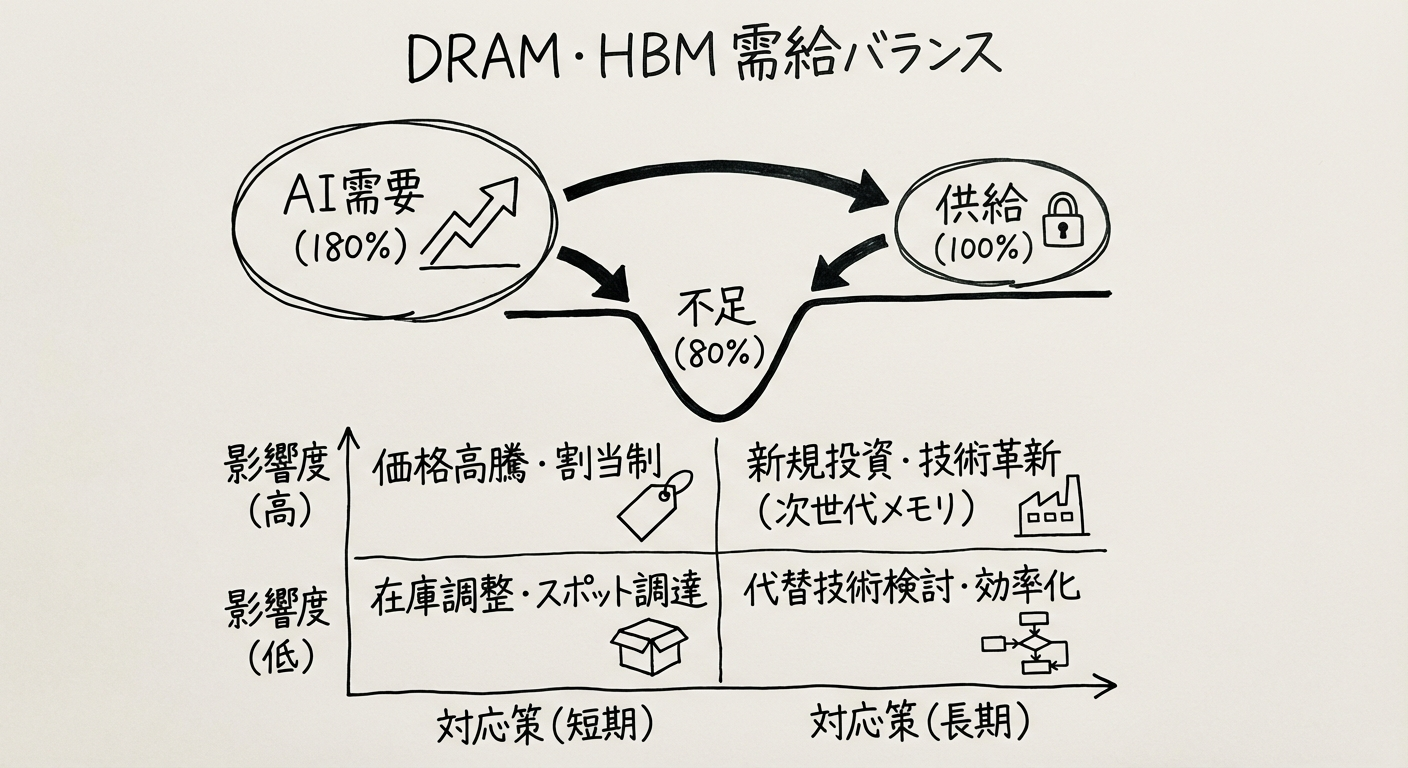

需給バランス:

| 種類 | 2025年供給 | 2026年需要 | 不足率 |

|---|---|---|---|

| HBM | 100% | 180% | 80%不足 |

| DDR5 DRAM | 100% | 140% | 40%不足 |

| LPDDR5 | 100% | 130% | 30%不足 |

出典: TrendForce 2026年Q1レポート

不足の原因:

- AI需要の爆発的増加: AIデータセンター向け需要が予想を大幅に上回る

- 生産能力の限界: 最先端メモリの製造キャパシティが追いつかない

- 技術的ボトルネック: HBMなど先端メモリの生産難易度が高い

- 投資不足: 過去のメモリ不況で設備投資が抑制されていた

HBMとは何か

HBM(High Bandwidth Memory)は、AI時代の必須技術です。

HBMの特徴:

- 高帯域幅: 従来DRAMの10倍以上のデータ転送速度

- 低消費電力: 効率的なデータアクセス

- 3D積層: 複数のDRAMダイを垂直に積み重ねる

- AI特化: GPU/AIチップに最適化

HBMの世代:

| 世代 | 帯域幅 | 容量 | 主な用途 |

|---|---|---|---|

| HBM2 | 256 GB/s | 8-16 GB | 旧世代AIチップ |

| HBM2E | 410 GB/s | 16-24 GB | 現世代AIチップ |

| HBM3 | 600 GB/s | 24-32 GB | Nvidia H100等 |

| HBM3E | 900 GB/s | 32-48 GB | Nvidia H200, B100 |

最先端のAIチップは、HBM3/HBM3Eを大量に必要とします。

なぜAIがメモリを大量消費するのか

AIモデル、特に大規模言語モデル(LLM)は、膨大なメモリを必要とします。

メモリ使用量の計算:

例: GPT-4クラスのモデル(1.76兆パラメータ)

- パラメータ数: 1.76兆

- 1パラメータ: 2バイト(FP16形式)

- 必要メモリ: 1.76兆 × 2バイト = 3.52 TB

これはモデル自体のサイズであり、推論時にはさらに以下が必要:

- 中間計算用メモリ

- バッチ処理用メモリ

- KVキャッシュ(コンテキスト保持用)

実際のGPU構成例:

- Nvidia H100(80GB HBM3)× 8枚 = 640 GB

- これでも1.76兆パラメータモデルの推論には不十分

- 実際には数十〜数百枚のGPUをクラスタ化

AI需要の拡大は、そのままメモリ需要の爆発を意味します。

メモリメーカーの戦略転換

高マージンHBMへのシフト

メモリメーカーは、収益性の高いHBMに生産能力を集中させています。

Samsung、SK Hynix、Micronの戦略:

従来(2024年):

コンシューマDRAM: 70%

HBM/サーバーメモリ: 30%

現在(2026年):

コンシューマDRAM: 40%

HBM/サーバーメモリ: 60%

シフトの理由:

| 製品 | 粗利率 | 単価 | 市場成長率 |

|---|---|---|---|

| DDR5 DRAM(PC用) | 20-30% | 低い | 5-10% |

| HBM3/HBM3E | 60-70% | 非常に高い | 50-80% |

HBMは、コンシューマDRAMの3倍以上の利益率を誇ります。

SK Hynixの圧倒的優位

HBM市場では、韓国のSK Hynixが圧倒的なシェアを持っています。

HBM市場シェア(2026年Q1):

- SK Hynix: 約50%

- Samsung: 約40%

- Micron: 約10%

SK Hynixの強み:

- 技術的リード: HBM3Eを最初に量産

- Nvidiaとの密接な関係: H100/H200向けに独占供給

- 製造キャパシティ: 大規模な生産能力

SK HynixのHBM売上は、2026年に前年比200%以上の成長が予想されています。

Samsungの追撃

Samsungは、SK Hynixに遅れを取ったものの、猛烈な追い上げを見せています。

Samsungの対策:

- 設備投資: 2026年に約1兆円をHBM生産に投資

- 技術開発: HBM3E+ の開発を加速

- 顧客開拓: AMD、Googleなどとの関係強化

Samsungの課題:

- Nvidiaの品質基準をクリアできず、供給が遅延

- SK Hynixとの技術差を埋める必要

Micronのコンシューマ撤退

米国のMicronは、最も劇的な戦略転換を実行しています。

Micronの決断:

- Crucialブランド閉鎖: コンシューマ向けメモリブランドを終了

- エンタープライズ特化: AIデータセンター向けに完全集中

- HBM投資: 広島工場でHBM生産を拡大

理由:

- コンシューマ市場の低収益性

- AI市場の高成長・高収益

- 限られた生産能力をAI向けに集中

この決断は、コンシューマ市場にとっては大きな打撃です。

コンシューマ市場への影響

PC・スマートフォンへの価格影響

メモリ不足は、コンシューマエレクトロニクスの価格に直接影響します。

価格上昇率(2025年末比):

| 製品 | メモリ価格上昇 | 製品価格上昇(予測) |

|---|---|---|

| ノートPC | 80-130% | 10-20% |

| スマートフォン | 60-100% | 5-15% |

| ゲーム機 | 90-120% | 15-25% |

| デスクトップPC | 100-150% | 15-30% |

出典: TrendForce、各種アナリストレポート

具体的な影響例:

- ミッドレンジノートPC: 10万円 → 12万円(+20%)

- ハイエンドスマホ: 15万円 → 17万円(+13%)

- ゲーミングPC: 25万円 → 32万円(+28%)

仕様ダウングレードの波

価格を維持するため、メーカーは製品仕様をダウングレードしています。

ダウングレード事例:

ノートPC:

- 従来: 16GB RAM標準

- 2026年: 8GB RAM(16GBはオプション、+2万円)

スマートフォン:

- 従来: ミッドレンジで8GB RAM

- 2026年: ミッドレンジで6GB RAM

ゲーム機:

- 次世代機の発売延期(メモリ確保が困難)

- 現行機の生産縮小

中古市場の活況

新品価格の高騰により、中古市場が活況を呈しています。

中古市場の動向:

- PC・スマホの中古価格が20-30%上昇

- メモリ増設済み中古PCの人気急上昇

- 「2024年モデル」の価値が上がる(メモリ仕様が良い)

DRAM価格の急騰

価格推移

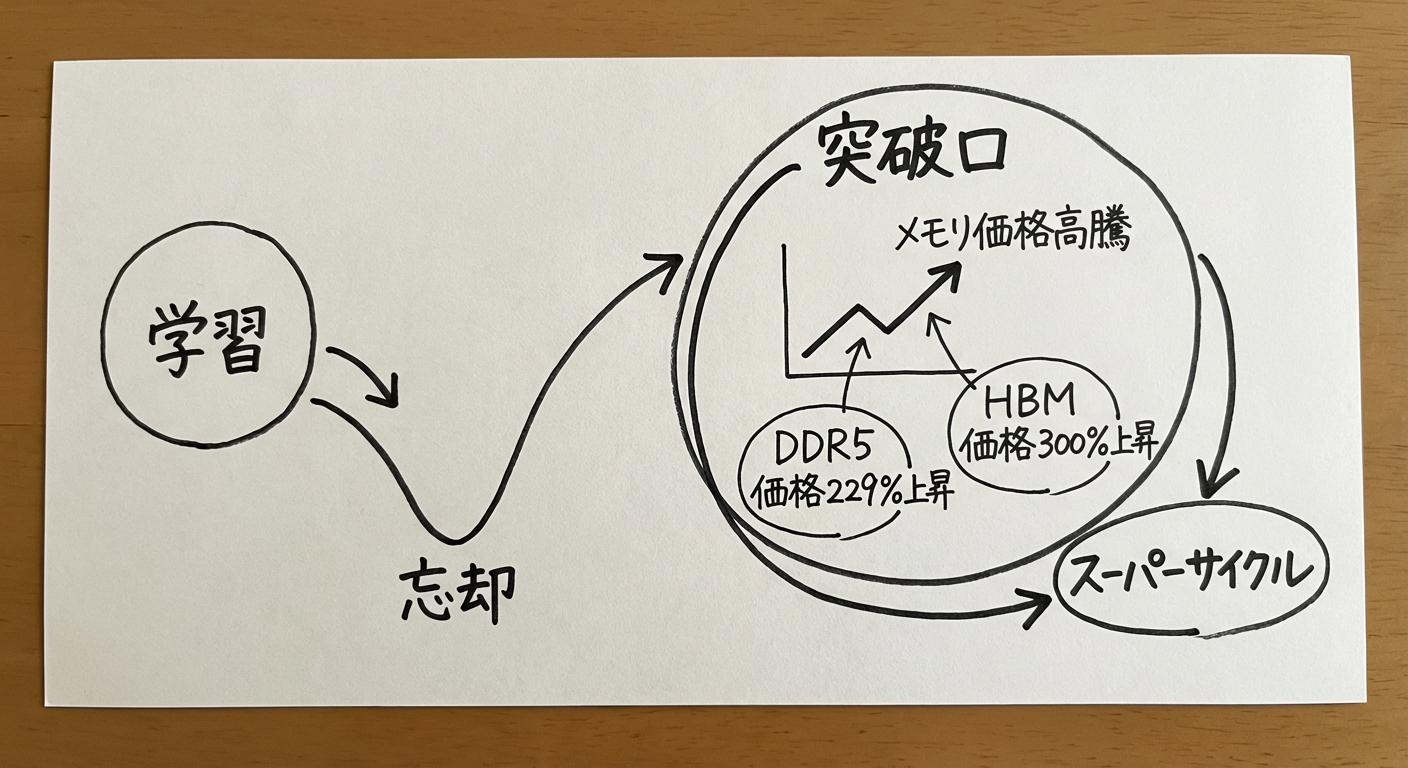

DRAM価格は、2025年末以来、急激に上昇しています。

DDR5 DRAM価格推移(8GB モジュール):

- 2025年1月: 約4,000円

- 2025年6月: 約3,500円(底値)

- 2025年12月: 約6,500円

- 2026年1月: 約8,000円(底値から229%上昇)

HBM3価格推移(16GB スタック):

- 2025年1月: 約5万円

- 2025年12月: 約12万円

- 2026年1月: 約15万円(前年比300%)

「スーパーサイクル」の到来

メモリ業界では、この価格高騰を「スーパーサイクル」と呼んでいます。

スーパーサイクルの特徴:

- 需要主導: AIという構造的な需要増加

- 長期継続: 2027年まで続く見込み

- 高収益: メモリメーカーの利益率が過去最高水準

過去のメモリサイクルとの比較:

| サイクル | 期間 | 価格上昇率 | 要因 |

|---|---|---|---|

| 2016-2018 | 2年 | 150% | スマホ需要 |

| 2020-2021 | 1年 | 120% | コロナ特需 |

| 2025-2027 | 2年 | 200-300% | AI需要 |

今回のサイクルは、過去最大級の規模です。

誰が利益を得るのか

この価格高騰で、明暗が分かれます。

勝者:

- メモリメーカー: Samsung、SK Hynix、Micronは過去最高益

- AIハイパースケーラー: 大量調達により優先供給を確保

- 中古市場: 中古PC・スマホの価値上昇

敗者:

- コンシューマ: PC・スマホの価格上昇

- 中小PCメーカー: メモリ確保が困難、価格競争力低下

- 新興国市場: 低価格PCが入手困難に

AI インフラへの影響

データセンター建設の遅延

メモリ不足は、AIデータセンターの建設計画にも影響しています。

影響を受けるプロジェクト:

- Microsoft: Copilot拡大のためのデータセンター

- Google: Gemini推論インフラ

- Meta: Llama推論クラスタ

- OpenAI: GPT-5学習インフラ

遅延の内容:

- GPU調達は可能だが、HBMが不足

- HBM確保のため、データセンター稼働が数ヶ月遅延

- 一部プロジェクトは2027年に延期

推論コストの上昇

HBM不足により、AI推論コストが上昇しています。

コスト上昇:

- GPT-4クラスモデルの推論コスト: +30-50%

- Claude Opusクラスモデル: +40-60%

- オープンソースモデル(Llama等): +20-30%

これは、AIサービスの価格転嫁につながる可能性があります。

オンプレミスAI導入の困難

企業がオンプレミスでAIを導入する際、メモリ不足が障壁となっています。

課題:

- GPU入手難: メモリ付きGPUの納期が1年以上

- 高価格: メモリ価格高騰により、初期投資が膨大

- 優先順位: ハイパースケーラーが優先され、一般企業は後回し

中小企業にとって、AI自社運用のハードルが大幅に上がっています。

日本への影響

日本のメモリ産業

日本はかつてDRAMで世界トップシェアを誇りましたが、現在は衰退しています。

日本メモリ産業の現状:

- DRAM: ほぼゼロシェア(Elpida破綻後、Micronに統合)

- NAND Flash: Kioxia(旧東芝メモリ)が世界シェア約15%

- HBM: 国産メーカーなし

日本の課題:

- メモリを完全に海外依存

- AI時代の重要技術を国内で確保できない

- ソブリンAI戦略にとってリスク

Kioxiaの機会

NAND Flashメーカーのキオクシア(Kioxia)には、HBM市場参入の機会があります。

Kioxiaの強み:

- 3D積層技術(NANDで培った)

- 先端半導体製造技術

- 日本国内での生産能力

課題:

- HBMはDRAM技術(Kioxiaは NAND専業)

- SK Hynix、Samsungとの技術差

- 大規模投資が必要

とはいえ、日本のAI主権にとって、国産HBMは重要な戦略資産です。

日本企業への影響

メモリ不足は、日本企業のAI導入にも影響します。

短期的影響(2026年):

- AI導入コスト上昇: オンプレミスAIの初期投資が増大

- クラウドコスト上昇: クラウドAIサービスの価格上昇

- PCリプレース遅延: 企業PCのメモリ不足で買い替え延期

中長期的対策:

- クラウドシフト: オンプレミスからクラウドAIへ

- 効率化: 少ないメモリで動作する軽量モデル活用

- 戦略的調達: 重要なメモリは長期契約で確保

技術的対策とイノベーション

メモリ効率化技術

メモリ不足に対応するため、効率化技術が急速に発展しています。

主要技術:

1. モデル圧縮:

- 量子化: FP16 → INT8 → INT4 (メモリ使用量 1/2 → 1/4)

- プルーニング: 不要なパラメータ削除

- 蒸留: 大モデルの知識を小モデルに転移

2. メモリ最適化:

- FlashAttention: Attentionメカニズムの効率化

- Gradient Checkpointing: 学習時のメモリ削減

- 混合精度学習: FP32とFP16の組み合わせ

3. 新アーキテクチャ:

- Mixture of Experts(MoE): アクティブパラメータ削減

- State Space Models: Transformerより効率的

- LoRAなどの適応手法: フルモデルを使わずカスタマイズ

これらの技術により、メモリ不足を部分的に緩和できます。

次世代メモリ技術

HBMを超える次世代メモリ技術の開発も進んでいます。

候補技術:

1. HBM4(2027年登場予定):

- 帯域幅: 1.5 TB/s以上

- 容量: 64-96 GB

- 消費電力: さらに削減

2. CXL(Compute Express Link):

- CPU-GPU間のメモリ共有

- メモリプール化

- 柔軟なメモリ割り当て

3. 新材料メモリ:

- MRAM: 不揮発性、高速

- ReRAM: 高密度、低消費電力

- PCM: 大容量、不揮発性

これらが実用化されれば、メモリ制約が大幅に緩和される可能性があります。

アルゴリズムイノベーション

メモリ制約は、アルゴリズムイノベーションを促進します。

注目のアプローチ:

- DeepSeekの低コストモデル: 少ないメモリで高性能

- Anthropicの効率化: Claude Opusの最適化技術

- Googleの Sparseモデル: メモリ効率の高いアーキテクチャ

「メモリが足りないなら、アルゴリズムで解決する」という発想です。

今後の展望

2026-2027年の予測

メモリ危機は、2027年まで続くと予想されます。

タイムライン:

2026年Q1-Q2:

- 危機のピーク

- 価格は高止まり

- コンシューマ製品の値上げラッシュ

2026年Q3-Q4:

- メーカーの増産効果が徐々に現れる

- ただし、需要も増加し続ける

- 価格はやや軟化するが、高水準維持

2027年:

- 新規生産能力の本格稼働

- 需給バランスが徐々に改善

- 価格は緩やかに下落開始

構造的変化

メモリ危機は、一時的な現象ではなく、構造的な変化を示唆しています。

新しい市場構造:

従来(〜2025年):

コンシューマ市場がメモリ需要の中心

メーカーはコンシューマ向けに最適化

新構造(2026年〜):

AI市場がメモリ需要の中心

メーカーはAI向けに最適化

コンシューマは「余った分」を使う

この構造変化は、不可逆的である可能性が高いです。

長期的影響

メモリ危機は、AI業界とコンシューマ市場の両方に長期的影響を与えます。

AI業界:

- メモリ効率化技術の加速的発展

- 新しいアーキテクチャの台頭

- エッジAI(少ないメモリで動作)の重要性増大

コンシューマ市場:

- ハイエンド製品の高価格化

- ミッドレンジ製品の性能停滞

- 製品買い替えサイクルの長期化

メモリ産業:

- 空前の収益

- 大規模設備投資

- 新規参入の誘発(ただし技術的ハードルは高い)

まとめ

AI需要による DRAM・HBM不足は、2026年のテック業界最大の危機の一つです。この危機は、AIスケーリングの物理的限界を示しており、業界全体に大きな影響を与えています。

重要なポイント:

- 供給不足: AI需要が供給を大幅に上回る

- 価格高騰: DRAM価格が80-130%、HBM価格が200-300%上昇

- 市場構造変化: AI市場優先、コンシューマは二の次

- 長期化: 危機は2027年まで続く見込み

対策:

- 企業: クラウドシフト、効率化技術の活用

- コンシューマ: 買い替え延期、中古市場活用

- 日本: 国産メモリ技術の再興検討

メモリ危機は、AI時代の新しい現実です。この制約の中で、どう適応し、イノベーションを起こすかが、企業と国家の競争力を決めることになるでしょう。

関連記事: