Human-Centered AI(人間中心のAI)完全ガイド - HITL/HOTL/HOOTLフレームワークで実現する安全なAI導入

2026年、AI技術は急速に進化し、企業活動のあらゆる側面に浸透しつつあります。しかし、AIの高度化に伴い「人間の役割はどうなるのか」「AIに任せて安全なのか」という根本的な問いが浮上しています。

その答えとして注目されているのが、Human-Centered AI(HCAI、人間中心のAI)という設計思想です。HCAIは、AIを単なる自動化ツールとして捉えるのではなく、人間の能力を増幅し、人間の主体性(Human Agency)を保持することを最優先とするアプローチです。

本記事では、メリーランド大学のBen Shneiderman教授が提唱するHCAI理論、Stanford HAI(Human-Centered AI Institute)の研究成果、そして実践的なフレームワークであるHITL(Human-in-the-Loop)、HOTL(Human-on-the-Loop)、HOOTL(Human-out-of-the-Loop)について詳しく解説します。さらに、医療、自動運転、製造業、金融業界での具体的な応用事例と、EU AI ActやJapan AI Guidelinesに準拠した導入戦略を提案します。

Human-Centered AI(HCAI)とは何か

HCAIの定義と歴史的背景

Human-Centered AI(HCAI)は、「高度な自動化」と「高度な人間制御」を同時に実現することを目指す設計思想です。従来のAI開発は「自動化レベルが上がれば人間の関与は減る」というゼロサムゲーム的な考え方でしたが、HCAIはこの前提を否定します。

メリーランド大学名誉教授のBen Shneidermanは、2022年の著書『Human-Centered AI』において、この革新的なフレームワークを提唱しました。Shneidermanは、従来の「Sheridan and Verplankの自動化レベル(レベル1〜10)」が設計思考を制限すると主張し、2次元フレームワークを提案しました。

この2次元フレームワークでは、「人間制御(Human Control)」と「コンピュータ自動化(Computer Automation)」を独立した2つの軸として配置します。目指すべきは、両軸が共に高い「右上象限」です。この領域にあるシステムを、Shneidermanは「Supertools(超ツール)」と呼びます。

Supertoolsの具体例:

デジタルカメラは、オートフォーカスや自動露出調整という高度な自動化を備えながらも、撮影者が構図を決定し、シャッターを切るタイミングを完全にコントロールできます。これこそが「高自動化・高人間制御」の理想形です。

Stanford HAI(Human-Centered AI Institute)の役割

Stanford HAI(Human-Centered AI Institute)は、AI研究、教育、政策の世界的ハブとして、HCAIの実践を牽引しています。Stanford HAIのミッションは、以下の3つの原則に基づいています:

- Human Impact(人間への影響): AIは効率性のためだけでなく、人間の状況を改善するために開発されるべき

- Augmentation(増幅): AIは人間を置き換えるのではなく、人間の能力を増幅するべき

- Intelligence(知性): 人間の知性を理解することで、より良いAIを構築できる

2024-2025年の主要な研究成果:

- 学際的研究助成: 2024/25年度には、「患者エンパワーメントのためのAI(臨床レポート要約)」や「Shuno(聴覚健康モニタリング)」など、患者の主体性を重視したプロジェクトに助成金が授与されました。

- Foundation Modelsの透明性: Center for Research on Foundation Models(CRFM)は、大規模言語モデル(LLM)の透明性インデックスを確立し、「ブラックボックス」システムがHCAIの説明可能性原則に違反することを指摘しています。

HCAIの4つの基本原則

HCAIフレームワークは、以下の4つの不可欠な柱に基づいています:

- Human Agency(人間の主体性): システムの結果に対して人間が自由に選択し、コントロールを維持できる能力

- Explainability(説明可能性): システムは、人間のオペレーターが理解できる形で出力の根拠を提供しなければならない

- Transparency(透明性): データの出所、モデルのロジック、システムの限界が可視化されていること

- Trustworthiness(信頼性): 信頼性の高い文化、安全性、独立した監視メカニズムを通じて達成される

HITL/HOTL/HOOTLフレームワークの詳細

HCAIの実践的な実装は、具体的なインタラクションモデルを通じて実現されます。これらは単なる技術的構成ではなく、責任、速度、リスクを決定する組織設計の選択です。

Human-In-The-Loop(HITL): 人間がループ内

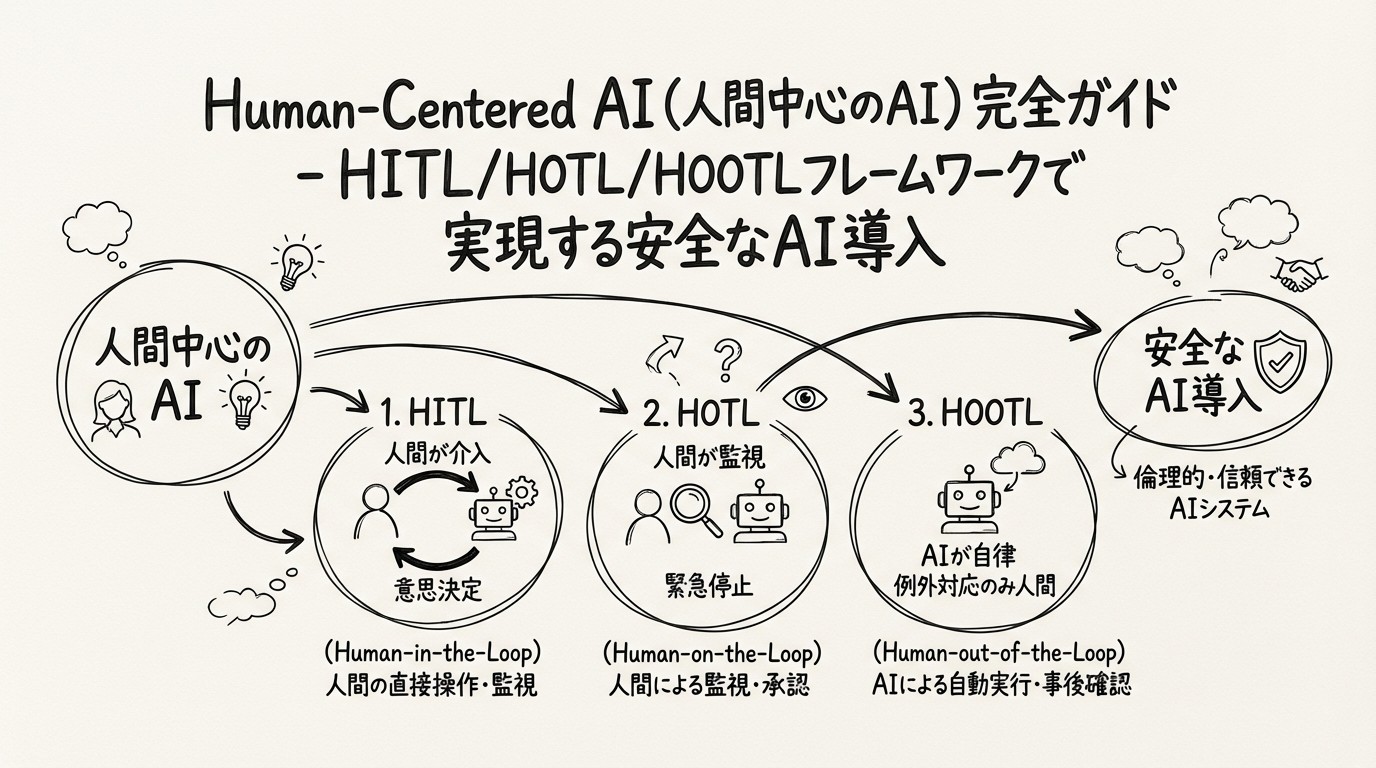

図1: HITL/HOTL/HOOTLフレームワークの違いと適用領域

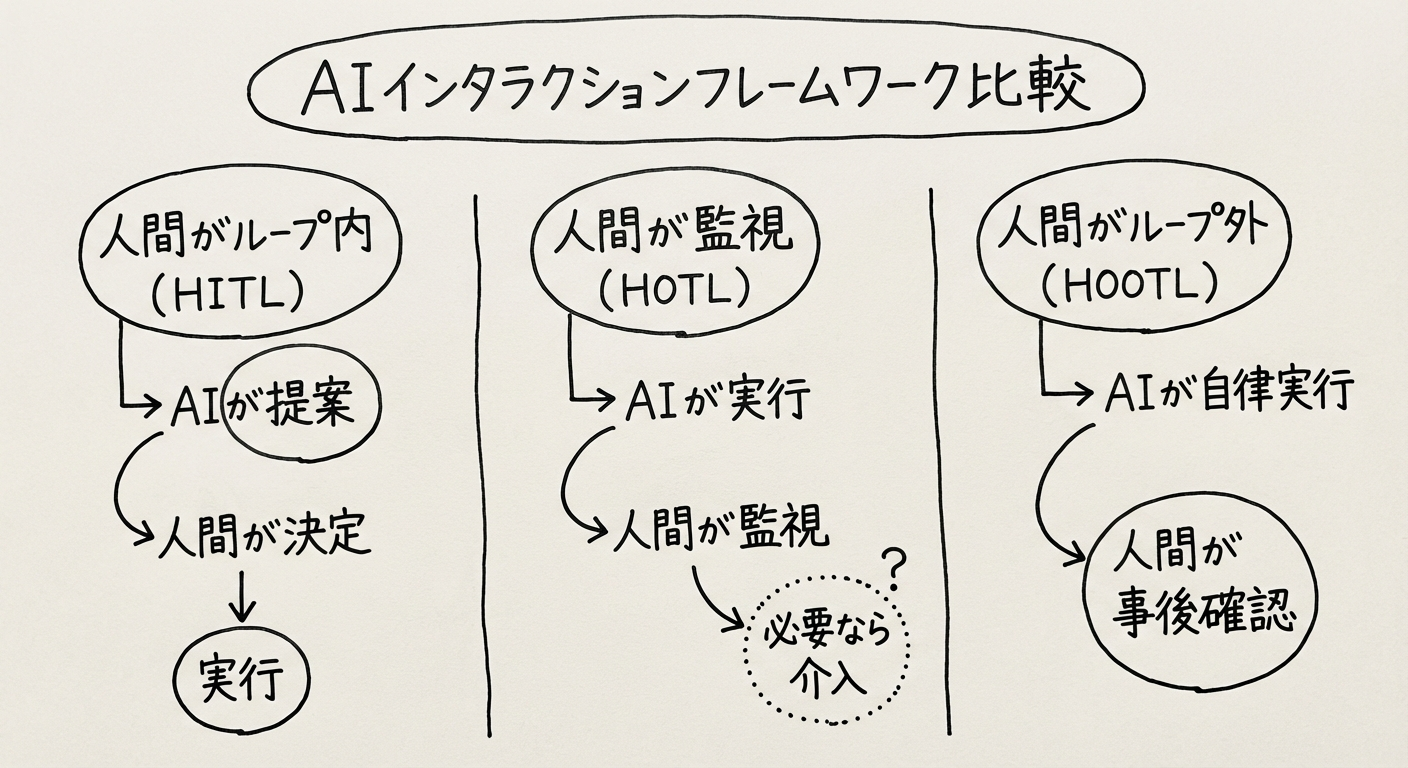

定義: HITLシステムでは、機械は人間の積極的な承認なしに最終決定を実行できません。人間は実行サイクルにおける重要なノードです。

仕組み: AIは推奨事項または部分的なタスク完了を提供し、人間がプロセスを進めるために「承認」する必要があります。

適用領域: エラーのコストが受け入れられない高リスク環境、または道徳的判断が必要な場合に使用されます。

実例:

- ローン審査: AIによって「ボーダーライン」とフラグ付けされたローン申請は、人間の審査担当者が文脈をレビューし、承認を行う必要があります。

- コード生成AI: 開発者は、LLMが提案したコードをレビューし、コンパイルしてから展開する必要があります。

長所と短所:

- ✅ 高い安全性と説明責任: 人間が最終決定を行うため、リスクが低減

- ❌ 低速度・低スケーラビリティ: 人間がAIのペースに追いつけない場合、ボトルネックが発生する可能性

Human-On-The-Loop(HOTL): 人間が監視

定義: システムはタスクを自律的に実行しますが、人間の監督者がリアルタイムで操作を監視し、即座に介入または上書きする能力(いわゆる「キルスイッチ」または「引き継ぎ」)を保持します。

仕組み: 人間はすべてのアクションを承認するのではなく、例外的に管理します。オペレーターは「参加型」ではなく「監督型」です。

適用領域: 迅速な反応時間を要求する動的環境で、継続的な人間の入力は非効率だが、完全な自律性は安全でない場合に使用されます。

実例:

- レベル3自動運転(メルセデス・ベンツ Drive Pilot): 特定の条件下で車が自動運転しますが、アラートが発せられた場合、ドライバーは数秒以内に引き継ぐ必要があります。

- サイバーセキュリティ脅威対応: AIが日常的な攻撃をブロックしますが、人間のアナリストが異常を監視し、複雑な侵害時に介入します。

長所と短所:

- ✅ 効率性と制御のバランス: 高速実行と人間監視を両立

- ❌ 自動化バイアスのリスク: 人間が受動的になりすぎて、必要な時に効果的に介入できなくなる可能性(状況認識の喪失)

Human-Out-Of-The-Loop(HOOTL): 人間がループ外

定義: システムは定義された境界内で完全な自律性を持って動作します。人間の関与は、目標設定、制約定義、事後監査に限定されます。

仕組み: ループは人間の介入なしに閉じられます。人間は「実行」フェーズではなく、「設計」および「評価」フェーズに関与します。

適用領域: 低リスク・高ボリュームタスク、または人間の反応時間が遅すぎるシナリオ。

実例:

- 高頻度アルゴリズム取引: 取引はミリ秒単位で行われます。

- スパムフィルタリング: メールの自動分類。

- クラウドコンピューティングの動的リソーススケーリング: サーバー負荷に応じた自動スケール。

長所と短所:

- ✅ 最大速度とスケーラビリティ: 人間の介入なしに大量処理が可能

- ❌ 暴走エラーの高リスク: システムが分布外データ(ブラックスワンイベント)に遭遇した場合の危険性

業界別の実践事例:医療、自動運転、製造業、金融

医療分野:遠隔操作から拡張知能へ

医療分野は、患者の安全性が最優先されるため、主にHITLを採用していますが、診断ワークフローはHOTLへとシフトしつつあります。

手術ロボット「ダビンチ5」(HITL)

2024年にFDA承認を取得したダビンチ5システムは、HITLの最高峰です。このシステムは自律型ではなく、外科医の動きをロボットに翻訳する遠隔操作システムです。

- HCAI機能: ダビンチ5はForce Feedback(力覚フィードバック)技術を導入し、外科医がコンソールを通じて組織の張力を「感じる」ことができます。これにより、人間の感覚的制御が向上し、Shneidermanの「Supertool」概念と完全に一致します。つまり、より多くの技術が、より多くの人間の熟練を可能にするのです。

- 計算能力: 前モデルの10,000倍の計算能力を持つにもかかわらず、システムは外科医の自律性を高めるために設計されており、置き換えることを目的としていません。

放射線診断(HOTL/HITL)

AIは放射線学において「セカンドリーダー」として機能します。

- ワークフロー: AIが画像をスキャンし、異常をフラグ付け(HOTL)。放射線科医がこれらのフラグをレビューして診断(HITL)。この「Physician-in-the-Loop」モデルにより、AIの感度(潜在的な問題の発見)と人間の特異性(偽陽性の除外)がバランスされます。

自動運転:レベル3の最前線

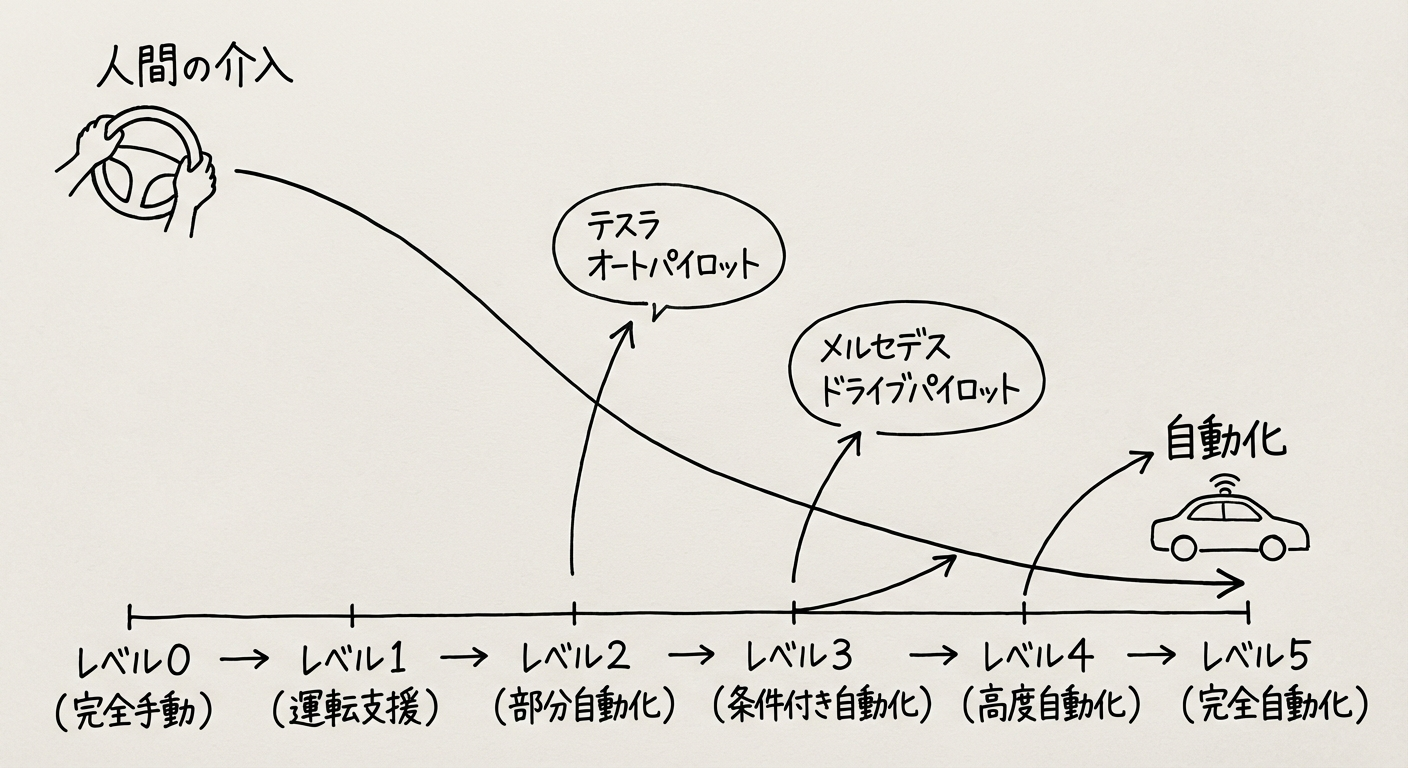

自動車業界は、HITLとHOTLの明確な区別を提供します。

レベル2(HITL): Tesla Autopilotのようなシステムでは、ドライバーはハンドルを握り、道路を注視する必要があります。人間が主要ドライバーであり、AIは補助します。

レベル3(HOTL): メルセデス・ベンツ Drive Pilotは、ネバダ州とカリフォルニア州(2023/2024年)およびドイツ(2024年末に最高95 km/h)で承認されており、渋滞時にドライバーがハンドルと視線を外すこと(例:映画鑑賞)を許可します。

- ループの仕組み: 車がパイロットです。人間は「フォールバック準備ユーザー」です。システムが未定義の状況に遭遇した場合、引き継ぎを要求します。人間が応答しない場合(例:医療緊急事態)、車は安全に停止します。これが典型的なHOTLアーキテクチャです。

図2: 自動運転レベル別の人間関与モデル

製造業:Industry 5.0とCobot(協働ロボット)

Industry 4.0は自動化(HOOTL)に焦点を当てていましたが、Industry 5.0は人間中心性(HITL)に焦点を当てています。

Collaborative Robots(Cobots)

従来の産業用ロボットは人間から隔離されていましたが(HOOTL)、Cobotsは人間と並んで作業します(HITL)。

- ユースケース: 組立ラインで、Cobotが重いフロントガラスを持ち上げ(自動化)、人間が正確な配置を誘導(制御)します。これにより、物理的負担を軽減しながら、人間の器用さと判断力を活用します。

- 2024年の研究: 「スマート製造におけるHuman-in-the-loop(H-SM)」に関する研究が進展しており、ウェアラブルデバイスとデジタルツインを使用して、人間の直感をデジタル生産ループに統合しています。

金融業界:リスクベースのフレームワーク選択

金融機関はリスクに基づいて階層的なアプローチを採用しています。

信用スコアリング(ハイブリッド)

- 低リスク(HOOTL): 完璧な信用スコアを持つ小規模ローンは自動承認されます。

- 高リスク(HITL): 大規模ローンまたはボーダーラインの信用スコアは「一時停止」をトリガーし、人間のローンオフィサーにルーティングされます。この「例外時のHuman-in-the-Loop(HITLFE)」モデルが業界標準になりつつあります。

詐欺検知(HOTL)

AIシステムは、異常を検出した際に即座にカードを凍結します(HOOTLアクション)が、人間のアナリストが詐欺を確認するか、アカウントをロック解除するためにケースをレビューします(HOTL監視)。

学術的背景と研究トレンド(2023-2025年)

文献の進化

学術的議論は、「信頼較正(2018-2020年)」から「協働的主体性(2023-2025年)」へと移行しています。

- Ben Shneiderman(2022年): 彼の著書は依然として基礎的テキストであり、「Human-Centered AI」を第2のコペルニクス革命と位置づけ、機械ではなく人間を宇宙の中心に置くことを主張しています。

- Stanford HAI(2024年): 最近のレポートは、AIの「社会的影響」を強調しています。2024年のAI Index Reportは、AI能力と公衆の信頼のギャップを浮き彫りにし、このギャップを埋めるためのHCAIフレームワークの必要性を強調しています。

新興概念

AI-in-the-Loop(AI²L)

2024年のarXiv論文は、HITL命名法に異議を唱え、多くの現代システムでは人間が主要エージェントであり、AIが人間のループに挿入されるアシスタントであると提案しています。この用語の逆転(AI-in-the-loop vs. Human-in-the-loop)は、人間の主体性へのより深いコミットメントを反映しています。

Industry 5.0

International Journal of Precision Engineering and Manufacturing(2024年7月)の研究は、Human-Centric Manufacturingの「5I」柱を定義しています:Intelligence(知性)、Integration(統合)、Interoperability(相互運用性)、Interaction(相互作用)、Immersion(没入)。これにより、製造ループにおける創造的問題解決者としての人間の役割が正式化されました。

倫理的考慮と規制の動向

HCAIへの移行は、もはや任意ではなく、法律に成文化されつつあります。

EU AI Act: Article 14(人間監視)

EU AI Actは、2024年半ば/2025年から特定カテゴリーで完全に施行されており、「高リスク」AIシステムに対してHCAI原則を明示的に義務付けています。

Article 14の義務:

- 高リスクシステムは、効果的な人間監視を可能にするように設計されなければなりません。

- 監視モデル: 法は異なるモダリティを認識しています:

- Human-in-the-loop: バイオメトリック識別(例:警察の顔認識には2人の人間による検証が必要)

- Human-on-the-loop: 重要インフラおよび安全コンポーネント

- 能力要件: 人間が存在するだけでは不十分です。人間はシステムを上書きするための「必要な能力、訓練、権限」を持っている必要があります。これは、人間が盲目的にAI出力を受け入れる「ラバースタンプ」問題に直接対処しています。

Japan AI Guidelines(METI/MIC 2024年4月)

2024年4月、日本の経済産業省(METI)と総務省(MIC)は「AI事業者ガイドライン」を発表しました。

主要原則:

- 人間中心の哲学: ガイドラインは明示的に「人間中心のAI社会原則」を参照しています。

- アジャイルガバナンス: EUの厳格なリスク分類とは異なり、日本は「アジャイルガバナンス」を推進し、公平性、説明責任、透明性の原則への自発的だが厳格な遵守を奨励しています。

- 尊厳と自律性: ガイドラインは、AIが人間の尊厳や個人の自律性を侵害してはならないことを強調しており、Shneidermanの主体性概念と密接に一致しています。

説明責任と公平性

説明責任(Accountability)

HOTL/HOOTLシステムでは、「説明責任のギャップ」が大きな懸念事項です。レベル3の車がドライバーが合法的に映画を見ている間にクラッシュした場合、誰が責任を負うのでしょうか?メルセデス・ベンツは、Drive Pilotがアクティブな場合に責任を受け入れると表明しており、これは企業の説明責任における画期的な転換です。

バイアス(Bias)

HITLはAIバイアスの治療法としてしばしば提案されますが、研究は「バイアス注入」(偏見を持つ人間が中立的なAIを上書き)または「自動化バイアス」(人間が偏ったAIを修正しない)を警告しています。HCAIは、批判的思考を強制するためのインターフェースにおける「摩擦」を要求します。

企業への戦略的提言:適切なフレームワークの選択

HITL/HOTL/HOOTLの選択基準

企業は、ユースケースを2つの軸にマッピングする必要があります:エラーのコストと時間の重要性。

| フレームワーク | エラーのコスト | 時間の重要性 | 推奨ユースケース |

|---|---|---|---|

| HITL | 高 | 低/中 | 医療診断、採用、法的判決、高額ローン |

| HOTL | 高 | 高 | 自動運転、サイバーセキュリティ防御、産業安全監視 |

| HOOTL | 低 | 高 | 製品推奨、スパムフィルタリング、在庫再注文 |

段階的実装アプローチ

フェーズ1: HITL(トレーニング&信頼)

AIを「シャドウ」システムとして展開します。人間が作業を行い、AIが提案します。AI精度に関するデータが収集されます。

フェーズ2: HITLFE(例外処理)

AIがルーチンケースを処理(HOOTL-lite)、人間がエッジケースを処理します。これが「例外時のHuman-in-the-Loop(HITLFE)」モデルです。

フェーズ3: HOTL(監督)

信頼が成熟するにつれて、人間は監督役に移行し、システムが低信頼度を示した時にのみ介入します。

組織変革管理

リスキリング(再教育)

「実行者」から「監督者」(HOTL)への移行には、異なるスキルが必要です。従業員は、AIを操作するだけでなく、監視し、質問するためのトレーニングが必要です。

心理的安全性

従業員は、AIを上書きすることに対して安全であると感じる必要があります。組織が(安全のためであっても)AIを遅らせることに対して人間を罰する場合、HCAIは失敗します。

摩擦のための設計

HOTLにおける自動化バイアスを防ぐために、インターフェースは時折人間に挑戦するか、オペレーターが「ぼんやり」しないように重要なパラメータの積極的な確認を要求する必要があります。

まとめ:人間中心のAI時代へ

学術理論(ShneidermanのRST)、規制圧力(EU AI Act Art. 14)、技術能力(ダビンチ5、Drive Pilot)の収束により、Human-Centered AIは2025年以降の主要な軌道として確固たる地位を築いています。

HITL、HOTL、HOOTLの選択は、もはや単なる技術的決定ではありません。それは、組織のリスクプロファイル、倫理的立場、コンプライアンス姿勢を定義する戦略的決定です。真のHCAIは、人間をループから削除することを目指すのではなく、ループ内の人間の位置を高めることを目指します。機械がより強力になるにつれて、人間の主体性が最優先であり続けることを保証します。

AI導入を検討される企業の皆様には、単なる「自動化」ではなく、「人間増幅」としてのAIを目指すことをお勧めします。HCAIの原則とHITL/HOTL/HOOTLフレームワークを活用することで、安全性、倫理性、ビジネス価値を同時に実現できるAI戦略を構築できます。

AI COMMONでは、Human-Centered AIの原則に基づいた、お客様のビジネスに最適なAIソリューションの設計・導入をトータルでサポートしています。 HITL/HOTL/HOOTLフレームワークの適用やEU AI Act・Japan AI Guidelinesへの準拠についてご検討の方は、ぜひお気軽にご相談ください。

参考文献

-

Shneiderman, B. (2022). Human-Centered AI. Oxford University Press.

https://global.oup.com/academic/product/human-centered-ai-9780192845290 -

Stanford HAI (Human-Centered AI Institute). (2024-2025). Research Grants & AI Index Report.

https://hai.stanford.edu/ -

Intuitive Surgical. (2024). Da Vinci 5 System FDA Clearance.

https://www.intuitive.com/ -

Mercedes-Benz. (2024). Drive Pilot Level 3 Autonomous Driving System.

https://www.mercedes-benz.com/ -

European Commission. (2024). EU AI Act - Article 14: Human Oversight.

https://artificialintelligenceact.eu/ -

経済産業省・総務省. (2024年4月). 「AI事業者ガイドライン」

https://www.meti.go.jp/policy/it_policy/ -

International Journal of Precision Engineering and Manufacturing. (2024年7月). "Human-in-the-loop in Smart Manufacturing."

https://link.springer.com/journal/12541 -

arXiv. (2024). "Human-in-the-loop or AI-in-the-loop? A Perspective Shift for Collaborative Intelligence."

https://arxiv.org/ -

Checkify. (2023). "HITL, HOTL, HOOTL: Understanding Human-AI Interaction Models."

https://checkify.com/ -

IEEE Computer Society. (2023-2024). Papers on Human-Centered AI and Autonomous Systems.

https://www.computer.org/

📢この記事をシェアしませんか?

おすすめの投稿:

🤖 AIは人間を「置き換える」のではなく「増幅する」!Ben ShneidermanのHuman-Centered AI理論とHITL/HOTL/HOOTLフレームワークで、安全かつ倫理的なAI導入を実現する方法を徹底解説 #HCAI #AI倫理

引用しやすいフレーズ:

“Human-Centered AIは、人間の能力を増幅し、人間の主体性(Human Agency)を保持することを最優先とする設計思想です”

“HITL(Human-in-the-Loop): 人間がループ内で意思決定に関与し、AIは提案するが最終判断は人間が行う”

“EU AI Actは高リスクAIシステムに対して効果的な人間監視(Human Oversight)を義務化しています”

“ダビンチ5は10,000倍の計算能力を持ちながらも、外科医の自律性を高める「Supertool」として設計されています”